Les assurances européennes sont aujourd’hui plongées dans la préparation de l’implémentation des nouvelles règles prudentielles de Solvency II, alors que les assureurs et les réassureurs suisses sont déjà depuis plusieurs années sous le régime du Swiss Solvency Test (SST). Ces deux réglementations ont l’ambition d'être basée sur l’évaluation des risques des compagnies. Pourtant, les discussions sur ce sujet tournent essentiellement autour de la pertinence de telle ou telle mesure, ou sur les coûts de la mise à niveau des organisations. Contrairement à ce qui se passait lors des premiers temps de l’élaboration des règles de solvabilité basées sur le risque, peu d’attention est aujourd’hui portée sur le changement profond que cette régulation représente en termes de gestion des institutions.

L’industrie de l’assurance est ancienne et a fortement contribué à l’expansion des économies européennes aux xixe et xxe siècles. Elle reste aujourd’hui l’un des éléments indispensables à un sain développement de l’économie. Pendant très longtemps, la gestion des compagnies se limitait à la gestion des flux d’argent : tant que les primes acquises et les rendements financiers excédaient le paiement des sinistres et les dépenses de gestion, on estimait que la compagnie était profitable et a fortiori solvable. Les indicateurs de performance dérivés de cette approche étaient, et sont toujours, le ratio combiné « primes/sinistres plus coûts » dans l’assurance aux biens et, dans l’assurance-vie, le rendement technique, le ratio « revenus bruts (primes et rendements financiers)/primes encaissées ». Encore aujourd’hui, ces mesures de performance prévalent dans la communication des entreprises et dans les articles qui leur sont consacrés par les médias.

Pourtant, la pression des marchés financiers, la régulation des banques et la nouvelle régulation de l’assurance basée sur l’évaluation des risques entraînent l’introduction progressive d’autres mesures de performance telles que le rendement sur action ou le rendement sur capital-risque. Elles sont toutes reliées à la notion de risque souscrite par l’assureur. Il ne s’agit plus seulement de savoir de combien les flux d’argent sont positifs, mais bien plus de savoir si les rendements obtenus sur un contrat sont proportionnels aux risques encourus dans ces contrats. La notion de capital devient ainsi centrale dans cette problématique. Il faut à la fois évaluer ce capital et l’allouer correctement aux différentes affaires souscrites par l’assureur. Cela implique un profond changement de mentalité et d’organisation pour satisfaire à ces exigences. Les assureurs-vie furent les premiers à introduire des méthodes statistiques pour calculer leurs primes avec les tables de mortalité qui sont devenues populaires à la fin du xixe siècle. Le calcul actuariel des primes et des réserves d’assurance s’est répandu et n’a cessé de se renforcer jusqu’à nos jours. Pourtant, l’actuaire restait typiquement confiné dans des domaines bien précis et ne participait pas directement à la gestion des compagnies. On lui demandait d’évaluer le besoin de réserves et de calculer les primes, mais jamais son avis sur le type d’affaires à développer ou sur le rendement de celles qui étaient souscrites.

L’introduction de la gestion du risque dans la gestion de l’assurance change complètement la perspective et le rôle des actuaires traditionnellement chargés d’évaluer quantitativement les risques encourus. La direction de la compagnie se doit de porter son attention à la fois sur les nouveaux indicateurs de performance et sur la gestion du capital de la compagnie pour que son utilisation soit optimale. La pression des marchés est renforcée par les exigences réglementaires pour amener les entreprises à repenser leur mode de fonctionnement et leur modèle d’affaires. Dans cet article, nous explorons quelques-uns des points clés de cette évolution et proposons des voies pour l’améliorer, basées à la fois sur l’expérience d’un grand réassureur international et sur notre compréhension des enjeux auxquels le monde de l’assurance se trouve aujourd’hui confronté.

Le capital-risque et sa gestion

À partir des années 1990, la notion de capital-risque est devenue dominante dans les banques sous l’influence du Comité de Bâle et l’avènement de la régulation liée aux risques. L’extension de cette notion aux assurances et autres institutions financières est arrivée très tôt. Aujourd’hui, la gestion du capital est devenue un élément central de l’agenda des directions des compagnies. Le capital est conçu comme la garantie offerte aux clients du paiement des obligations de l’institution financière jusqu’à une certaine probabilité (généralement de 99 % pour les banques et de 99,5 % pour les assurances). Il représente donc en quelque sorte la « matière première » utilisée par les sociétés pour générer des affaires et des profits. Il s’agit par conséquent de le gérer au mieux pour optimiser le rendement de la compagnie. Cela implique que son allocation ne soit pas traitée comme une question périphérique, mais soit placée, au contraire, au cœur de la gestion des affaires d’assurance comme de celles des banques1.

Le capital est utilisé par l’assureur comme garantie qu’il paiera au preneur d’assurance au-delà de la moyenne des sinistres de ce type de polices, mais jusqu’à une certaine limite déterminée à une probabilité très faible. La question naturelle qui s’ensuit est de savoir combien de capital la compagnie a-t-elle besoin pour les risques qu’elle détient dans son portefeuille et à quel horizon de temps. À ce point de notre raisonnement, il est utile de distinguer deux types de capital qui vont jouer un rôle important dans la détermination de la solvabilité de la compagnie, mais aussi dans la gestion de ses objectifs de rendement. Il y a, d’une part, le capital disponible Ce dans le bilan de la firme, appelé aussi parfois « capital économique », et, d’autre part, le capital minimum Cr que la compagnie devrait détenir pour faire face aux risques de son portefeuille, appelé « capital ajusté au risque ». Celui-ci correspond à la somme évaluée à partir d’une estimation actuarielle du risque combiné des actifs et des passifs de l’assureur. On définit alors le ratio S de solvabilité de la compagnie comme :

Ce ratio doit évidemment être supérieur à 1 pour que la firme puisse faire face à ses obligations et être solvable. L’horizon de temps généralement choisi est d’un an. C’est le cas aussi bien pour Solvency II que pour le SST. Nous allons discuter ici aussi bien du numérateur que du dénominateur du ratio S. Ce ratio s’avère central dans la communication de la solvabilité des assurances.

Commençons par le capital économique, ou capital disponible, Ce. Il est défini, dans les nouvelles règles de solvabilité, comme la valeur économique actuelle de la compagnie en considérant qu’elle ne souscrira plus d’affaires l’année suivante. C’est-à-dire qu’à l’instant t, on a :

Ce(t) = Ve(A(t)) – Ve(P(t)) (2)

où Ve représente la fonction donnant la valeur économique d’une variable. Ici, ces variables sont A pour les actifs et P pour les passifs. Cette valeur diffère de la valeur économique calculée par un investisseur au moment du rachat d’une entreprise. L’investisseur ajouterait à la valeur définie dans l’équation (2) une valorisation des affaires futures que la compagnie pourrait souscrire et des profits qui en résulteraient. Ve ne représente donc pas strictement la valorisation économique. Elle n’est que la pure transformation du bilan comptable en bilan économique. Ve permet le calcul de Ce à partir des différents éléments du bilan comptable sans autres considérations sur le futur de l’entreprise que les taux d’intérêt pour actualiser les cash-flows. Nous ne nous étendrons pas plus longuement sur Ve qui mériterait un article en elle-même. Passons à la définition du dénominateur de l’équation (1) en faisant remarquer que la définition de Ce doit être mise en relation avec celle du capital ajusté au risque Cr. En effet, il faudra ajuster la valeur du capital disponible Ce si Cr est défini de la façon traditionnelle en théorie du risque, c’est-à-dire comme variation par rapport à l’espérance mathématique :

Cr = E(X) – ρ(X) (3)

où X représente la variable aléatoire de changement, à un horizon Δt de la valeur économique de la compagnie (généralement la somme des variables aléatoires de tous les risques des actifs nA et des passifs nP), définie comme :

et ρ la mesure de risque choisie, généralement la valeur-à-risque (VaR) ou l’espérance mathématique des pertes au-delà d’un certain seuil (TVaR). On remarquera que X(t) n’est rien d’autre que le changement de Ce à l’horizon Δt :

X(t) = Ce(t + Δt) – Ce(t)

On voit donc bien que Cr et Ce sont indirectement liés et que la définition de l’un a des conséquences sur l’autre.

Si Cr est défini par l’équation (3), on ne pourra pas se contenter de l’équation (2) pour définir Ce, c’est-à-dire de traduire en termes économiques le bilan comptable pour obtenir le capital économique. Il faudra, en effet, ajouter à cette valeur de l’équation (2) l’espérance mathématique des profits à l’horizon de temps considéré : Ce = Ve(A) – Ve(P) + E(X). Ne pas le faire conduirait à refuser l’offre d’un billet de loterie dont le profit, même faible, est représenté par E(X). Dans ce cas, l’équation (3) devient Cr = E(X) alors que Ce = 0 (aucun capital préexistant, seulement un billet de loterie), ce qui impliquerait un ratio de solvabilité nul. Par contre, si l’on accepte que le capital économique Ce contienne les profits futurs, c’est-à-dire que Ce = Ve(A) – Ve(P) + E(X), l’offre pourrait être acceptée puisque le capital ajusté au risque serait compensé par un capital disponible équivalent et donc le ratio de solvabilité serait égal à 1. Cet exemple montre l’importance de la cohérence des définitions si l’on veut pouvoir calculer un ratio de solvabilité.

Dans le cas de Solvency II, on pourrait penser que le problème soit résolu puisque le capital Cr est directement défini comme la VaR à 99,5 % de X(t), et non suivant l’équation (3). Cependant, enlever l’espérance ne règle pas du tout le problème, au contraire, puisqu’il est possible de réduire les exigences en capital en étant simplement optimiste sur les revenus futurs et donc en augmentant E(X). Par simple effet de translation, la VaR, et donc Cr, se réduira alors d’autant. Être trop optimiste sur les profits futurs permet ainsi de réduire Cr tout en rendant paradoxalement la compagnie plus risquée puisque fonctionnant avec des attentes de profit irréalistes. Du point de vue d’une saine gestion des risques, on peut donc douter de la pertinence de cette définition simplifiée du Cr. Ce paradoxe ne semble pas avoir été remarqué par les autorités de surveillance européennes. Bien que la définition de Cr dans le SST utilise une autre mesure de risque (TVaR) avec un autre seuil, 99 %, elle souffre du même problème puisqu’elle ne prend pas en compte l’espérance mathématique des profits.

Il s’avère donc qu’il serait plus judicieux, du point de vue des incitations, de modifier la définition du capital économique selon :

Ce(t) = Ve(A(t)) – Ve(P(t)) + E(X(t))

et de conserver la définition de l’équation (3) pour le capital ajusté au risque Cr.

Nous ne nous attarderons pas plus longtemps ici sur la façon de calculer le capital économique à partir du bilan comptable. Les règles de Solvency II sont très précises à ce sujet (Commission européenne, 2015, pp. 49-57). Nous nous contenterons de signaler certaines questions qui ne sont pas résolues et qui ouvrent la porte à diverses interprétations qui sont âprement débattues en ce moment. L’une d’entre elles est de savoir quel taux d’intérêt doit être choisi pour escompter les passifs (Dacorogna, 2012). À ce jour, que ce soit l’European Insurance and Occupational Pensions Authority (EIOPA, l’autorité européenne de surveillance) ou la Finma (l’autorité fédérale suisse de surveillance des marchés financiers), les autorités de surveillance publient elles-mêmes leurs propres courbes de taux qui doivent être utilisées par les assureurs pour l’actualisation des passifs au lieu de choisir celles déduites des dernières valeurs des marchés financiers comme le voudrait la règle du mark-to-market. Une autre question est de savoir si le capital disponible est vraiment « disponible » en cas de situation de stress. En d’autres termes, la liquidité des moyens à la disposition de l’entreprise en cas de stress est un sujet de préoccupation d’où, pour les banques, la classification en trois tiers du capital, du plus liquide (1er tiers) au moins liquide (3e tiers), avec des exigences concernant la proportion de capital couvert par chacune des qualifications. Les traitements des dividendes et des impôts différés provoquent aussi des controverses que nous ne développerons pas ici.

Si la définition du capital économique est sujette à des imprécisions, celle du Cr l’est tout autant. Nous avons vu supra que ce n’est pas une définition rigoureuse du point de vue de la théorie du risque qui a été choisie par les autorités de surveillance, mais la mesure de risque diffère aussi d’un système à l’autre (voir pour une comparaison de Solvency II et de SST, Dacorogna et Keller, 2010). Outre la définition stricte, comme dans l’équation (2), de Ce, Cr dépend aussi de deux autres choix : celui de la mesure de risque (VaR, TVaR), ainsi que celui du seuil auquel elle est mesurée (99 %, 99,5 %). Il serait souhaitable que les pratiques s’harmonisent et que l’industrie s’entende sur une définition universellement reconnue. Malheureusement, nous ne semblons pas en prendre le chemin au niveau international au vu des débats entre les autorités américaines et européennes sur ce sujet.

Il n’en reste pas moins que chaque compagnie doit décider pour elle-même comment déployer son capital de façon optimale en s’appuyant sur sa propre stratégie et sur la méthode qu’elle a choisi pour allouer le capital aux différents risques. Tout assureur doit s’adapter pour réussir un tel exercice, tout en satisfaisant aux exigences des actionnaires, des autorités de surveillance, des agences de notation et des conditions propres à la marche de leurs affaires. Le triangle profitabilité, solvabilité et présence dans le marché devient l’espace à optimiser. Ces trois points sont bien sûr liés et il n’est pas possible de fixer l’un sans considérer les autres. D’où la question : quel est le capital suffisant pour satisfaire toutes ces contraintes ? L’art de la gestion du capital sera de fixer cette quantité pour permettre une rémunération adéquate des actionnaires tout en assurant la stabilité et la crédibilité financière de l’entreprise. Pour cette raison, la tendance des assureurs est actuellement de communiquer publiquement à la fois un objectif de rendement sur action (return on equity – ROE) et un intervalle pour le ratio de solvabilité défini en équation (1). Ces deux objectifs vont de pair et ne peuvent pas être fixés indépendamment l’un de l’autre. La relation dérivée dans Besson et al. (2008) nous donne une expression simple reliant le rendement cible que la compagnie se fixe à son ratio de solvabilité S :

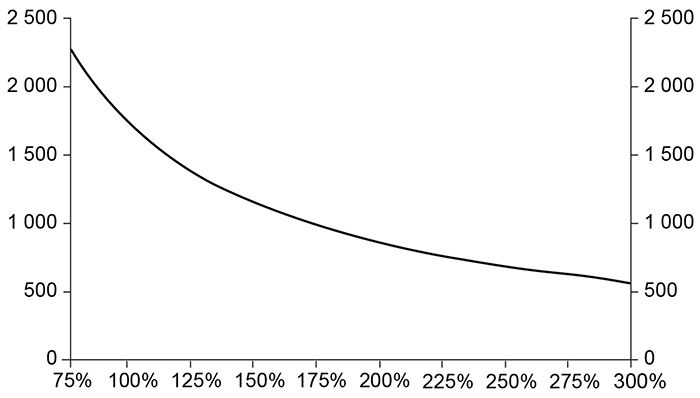

où μ est la prime de risque attribuée par le marché pour l’industrie à un niveau de solvabilité de 100 %. Une illustration de cette relation est donnée sur le graphique 1 où nous avons choisi ici un μ de 1 700 points de base au-dessus du taux sans risque. Cette valeur élevée est due au fait que le marché n’attend pas que les assurances opèrent à ce niveau de solvabilité, mais à un niveau bien supérieur2. Finalement, la direction de l’assurance devra décider de la quantité de capital nécessaire à sa stratégie en fonction de ces variables T, μ et S comme expliqué dans Besson et al. (2009).

La tâche de la direction sera donc de gérer au mieux le capital de façon à satisfaire les différentes parties prenantes aux affaires d’assurance ayant des points de vue contradictoires. Décrivons-les rapidement :

- les actionnaires pour qui le capital représente la valeur de leur investissement et qui voudront le maintenir aussi bas que possible pour obtenir les rendements les plus élevés ;

- les preneurs d’assurance et les autorités de surveillance qui les défendent ; ils ont intérêt à obtenir le plus grand capital possible de l’assurance puisqu’il est la garantie de paiement des passifs qu’ils ont contractés avec la compagnie ;

- les agences de notation qui auscultent la santé financière des assurances pour s’assurer de la qualité de leur risque de crédit ; elles attendent que l’entreprise ait suffisamment de capital pour justifier sa notation, mais elles s’inquiètent aussi de sa profitabilité ;

- enfin, la direction et le personnel qui utilisent le capital pour générer le profit de l’entreprise et qui doivent s’efforcer de satisfaire les exigences des autres parties prenantes des affaires d’assurance.

Ce constant travail de balancier sera le quotidien des compagnies modernes cherchant à s’adapter aux nouvelles conditions de marché et profiter des nouvelles règles régissant le secteur tout en développant leurs affaires sur le long terme.

La valorisation économique

À la base de l’évaluation du capital et des risques du métier d’assurance se trouve la valorisation économique des passifs et des actifs de la compagnie. En effet, nous venons de voir que le capital disponible est défini dans les règles de Solvency II comme la différence entre la valeur économique des actifs et celle des passifs (équation 2). La valorisation économique des actifs est assez simple pourvu que ces derniers soient valorisés dans des marchés suffisamment liquides. Dans ce cas-là, la valeur économique se réduit à trouver le prix du marché pour cet actif. C’est ce que l’on appelle dans le jargon comptable mark-to-market. La situation se complique lorsqu’on doit valoriser des actifs dans des marchés peu liquides ou même inexistants pour certains actifs dérivés négociés au gré à gré, ou des produits structurés comme les CDO (collateralized debt obligations). Lors de la crise financière de 2008-2009, certains de ces actifs ne trouvaient plus d’acheteurs et les institutions qui en possédaient ou qui les cédaient à des fonds d’État en étaient réduites à les valoriser à partir de modèles se basant sur le prix des actifs sous-jacents. C’est le fameux mark-to-model qui a permis aux plus habiles d’entre elles, comme Goldman Sachs, de passer entre les mailles du filet.

Nous venons de parler de la difficulté de valoriser les actifs non liquides, le problème s’en trouve décuplé avec les passifs d’assurance qui n’ont généralement pas de marché où ils sont négociés3. Cette question aura été au centre de nombreux débats lors de la mise en place de Solvency II. Il est important de rappeler ici les règles de cette valorisation pour bien en comprendre les enjeux. Les deux principes à la base de la valorisation des passifs sont :

- l’existence de marchés liquides pour les actifs et donc d’informations vérifiables sur leurs prix ;

- la loi du prix unique qui s’énonce comme suit : « Deux instruments financiers, dont les cash-flows sont identiques quel que soit le futur état du monde, auront le même prix de marché. »

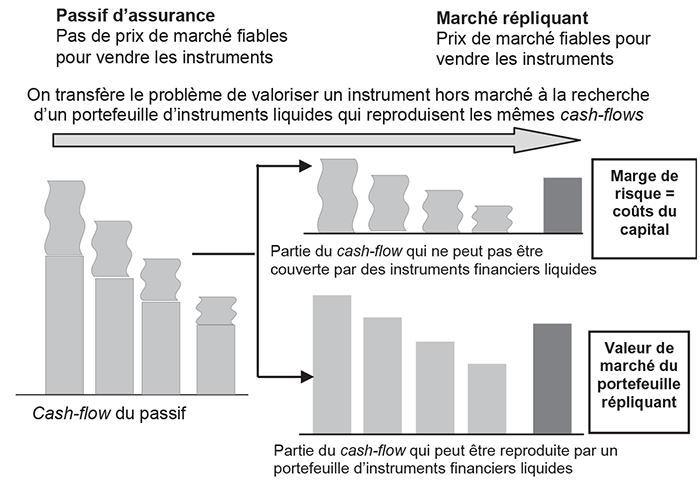

Cette loi, si elle s’applique, permet d’estimer aisément le prix d’un instrument financier en trouvant une combinaison d’instruments liquides qui reproduisent ensemble le cash-flow considéré. C’est l’idée du portefeuille répliquant qui trouve son origine dans un article du mathématicien suisse Leonhard Euler (1767) qui utilise un tel argument pour escompter des rentes viagères. On voit donc que l’approche consiste en fait à transférer le problème de valorisation d’un instrument n’ayant pas de marché, comme les passifs d’assurance, par la recherche d’instruments liquides dont les prix de marché sont facilement accessibles et fiables. Ils permettent ainsi d’obtenir directement l’information. Tout irait pour le mieux dans le meilleur des mondes si les passifs d’assurance n’étaient pas sujets à de violentes variations stochastiques provoquant une grande incertitude sur le résultat final du contrat. Ces variations ne trouvent pas d’équivalents négociables dans les marchés financiers. On n’échappe donc pas à la nécessité d’évaluer les risques liés à ces cash-flows et d’introduire une correction à la valeur du portefeuille répliquant appelée la « marge de risque » (risk margin). Cette marge de risque est définie comme le coût du capital que le propriétaire de ce passif doit immobiliser jusqu’à l’expiration du contrat pour faire face aux fluctuations non couvertes par le portefeuille répliquant.

Le schéma 1 (infra) représente le processus de valorisation des passifs d’assurance. Il montre que le problème se divise en deux. Il s’agit, d’une part, de choisir les instruments qui vont constituer le portefeuille répliquant et, d’autre part, de bien évaluer le risque restant une fois ce choix effectué. Ainsi, seulement le passif d’assurance pourra être correctement valorisé. La discussion entre assureurs et autorités de surveillance portait récemment sur le premier point (le choix des actifs) sans voir les conséquences qu’elle a sur le second point (la marge de risque). Les trois choix examinés par l’EIOPA avec le concours des assureurs sont :

- utiliser pour les instruments du portefeuille répliquant le taux sans risque ;

- ajouter au taux sans risque une prime pour le manque de liquidité de ces passifs qui serait en faveur de l’assureur ;

- ajuster le taux d’escompte aux actifs réellement détenus par l’assureur.

La première solution implique que l’on a éliminé le risque de crédit des risques à évaluer sur ces cash-flows. La deuxième implique que l’assureur détient des instruments peu liquides, ce qui en retour entraîne un risque supplémentaire si jamais il était amené à devoir réaliser ses actifs pour payer les sinistres. La troisième implique, en toute rigueur, qu’il faut ajouter le risque de défaut de ces actifs aux risques des passifs, ce qui bien sûr n’est pas considéré par l’EIOPA et les avocats des deux dernières solutions.

Nous venons de voir ci-dessus, mais aussi dans le schéma 1, que tout l’objet de l’exercice est de trouver des instruments qui soient liquides et dont le prix puisse être utilisé pour négocier ces instruments. Ce n’est évidemment pas le cas pour les deux dernières solutions proposées par l’EIOPA et les assureurs. Théoriquement, le portefeuille répliquant ne doit pas forcément contenir que des instruments au taux sans risque. Par contre, vu que ce risque ne peut pas être couvert par le marché, il faut l’ajouter à la prime de risque. Au total, si la valorisation est faite rigoureusement, la valeur ne devrait pas changer de manière significative. Elle serait simplement divisée différemment. Plus les instruments sont risqués, plus le prix des cash-flows des passifs sera bas, mais plus la marge de risque sera grande pour prendre en compte les risques de ces actifs. Le problème de la discussion actuelle sur le portefeuille répliquant est que la question de la réévaluation de la marge de risque n’est pas abordée. En ne s’intéressant qu’à la partie du portefeuille répliquant, on ne fait que réduire la valeur des passifs en ne les valorisant pas rigoureusement. Ces artifices sont recherchés par les autorités de surveillance et l’industrie pour faire face au faible niveau d’intérêt et lutter contre l’effet procyclique de la réglementation. Il y aurait pourtant d’autres méthodes plus naturelles qui ne se réduiraient pas à « briser le thermomètre parce qu’on a de la fièvre ». Nous en avons proposé une dans Besson et al. (2010) qui consisterait simplement à assouplir le seuil auquel le capital est mesuré (VaR) pendant une grave crise financière.

Certainement, la valorisation économique comporte des problèmes non résolus : le premier, que nous venons d’aborder, est la définition des actifs du portefeuille répliquant ; le deuxième est lié à la définition de la marge de risque. Cette dernière est définie comme le coût du capital qu’il faut détenir jusqu’à l’extinction des cash-flows du contrat. Là encore, deux ingrédients doivent être définis : le coût unitaire du capital qui est fixé arbitrairement à 6 % par Solvency II et le SST, et le capital qu’il faut avoir à chaque étape du paiement. Ce dernier suscite aussi des controverses. Pour une étude et une discussion approfondies sur la définition et le calcul des coûts du capital, on se référera à l’article original d’Auerbach (1983) qui pose les bases du problème. Il en souligne les difficultés et les limites. En principe, le capital nécessaire pour garantir le paiement dépend non seulement du risque sous-jacent, mais aussi du bénéfice de diversification qu’offre le portefeuille de l’assureur. Un même contrat aurait une valeur différente suivant qu’il se trouverait dans l’un ou l’autre des portefeuilles. Ce serait un problème pour les comptables qui voudraient introduire une telle valorisation pour les passifs. En effet, une telle valorisation contredirait l’un des principes de comptabilité qui est d’assurer la comparabilité des bilans. Cette contradiction se retrouve aussi dans la réglementation de Solvency II qui demande aux compagnies de calculer les marges de risque au niveau des entités légales et n’accepte pas de donner au réassureur, par exemple, le bénéfice de diversification de l’ensemble de son portefeuille. Cette différence peut être très significative dans le cas de la réassurance. Pour SCOR, par exemple, elle se chiffre en centaine de millions d’euros (Dacorogna et al., 2011) à déduire du capital disponible.

Un autre problème, rarement abordé et qui reste non résolu, est l’allocation du capital aux différentes étapes de paiement des cash- flows. Les actuaires non-vie sont en général capables de bien estimer le capital nécessaire pour couvrir le contrat jusqu’à l’ultime, mais la répartition de ce capital au cours du temps n’est pas facile et souvent approchée de façon très simple, faute d’une méthode générale. Si l’on utilise des méthodes de Monte-Carlo pour estimer le risque à l’ultime, il faudrait en principe le faire à chaque étape de paiement. Cela signifierait des calculs de simulations dans la simulation, ce qui bien sûr n’est pas possible pour des paiements qui s’étendent fréquemment sur plusieurs années. On a donc recours à des simplifications généralement assez grossières pour calculer la répartition du capital au cours du temps et pouvoir estimer ainsi la marge de risque sans calculs trop lourds. Des progrès dans ce domaine devront être réalisés dans les années qui viennent. En formulant des classes de processus stochastiques pour le développement des cash-flows, il devrait être possible de mieux coller à la réalité et d’éviter certaines des difficultés rencontrées par la valorisation économique des passifs d’assurance (Dacorogna et al., 2015).

Malgré tous ces obstacles, l’approche de la valorisation économique reste centrale au nouveau paradigme qui s’est établi dans l’industrie de l’assurance et qui ne va pas disparaître de sitôt. Les oppositions se cristallisent sur les faiblesses de la méthode en oubliant le progrès qu’elle représente dans la valorisation plus réaliste des affaires d’assurance et d’ailleurs des affaires en général parce qu’elle intègre les notions à la fois de temps, de risque et de marché comme véhicule de l’information.

Le modèle interne pour évaluer le capital

Nous nous tournons maintenant vers l’un des éléments centraux de ce changement de perspective qu’entraîne l’évaluation quantitative des risques des affaires d’assurance : la modélisation. Aujourd’hui, la réglementation européenne, que ce soit Solvency II ou le SST, encourage les compagnies à développer leurs propres modèles pour estimer leurs risques, ou leur offre l’alternative d’utiliser la formule standard de l’EIOPA ou le modèle standard de la Finma. Quel que soit le choix, les entreprises doivent de toute façon passer par une étape d’évaluation quantitative de leurs risques. Certains, comme les réassureurs, souvent à l’avant-garde dans ce domaine, n’ont pas attendu ces nouvelles législations pour se lancer dans la modélisation quantitative de l’ensemble de leur portefeuille d’affaires. Swiss Re, par exemple, développe depuis 1993 un modèle interne, alors que SCOR dispose de son propre modèle depuis 2003.

Le modèle interne permet de quantifier l’ensemble des risques auxquels la compagnie est exposée : les risques de souscription (vie etnon-vie), les risques de marché, les risques de crédit et les risques opérationnels. Il s’agit d’estimer le risque du bilan économique de la compagnie en modélisant la variable X(t), définie dans l’équation (4) à l’horizon d’un an. Cette variable est considérée comme une variable stochastique, généralement modélisée à l’aide de simulations Monte-Carlo basées sur la connaissance des distributions de probabilités des risques sous-jacents et de leurs dépendances. Comme il s’agit d’une projection à un an, les modèles internes incluent les données de planification, en plus des données comptables et actuarielles. L’intégration des différentes données de l’entreprise est d’ailleurs l’un des bénéfices collatéraux de ces modèles. Ils permettent une vue d’ensemble de tous les processus : planification, comptable et actuariel.

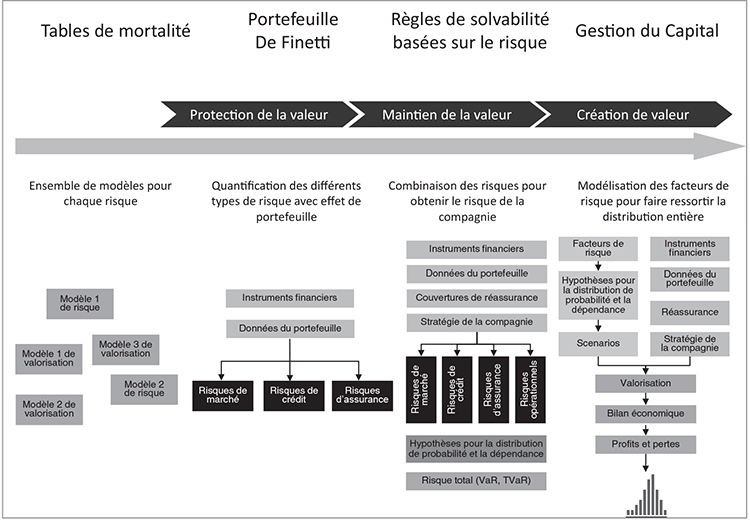

Au cours des années, ces instruments se sont sophistiqués et complexifiés, mais leur développement s’inscrit naturellement dans l’évolution de la modélisation dans l’assurance. Cette dernière est sans doute l’une des premières industries à avoir eu systématiquement recours à la quantification de ses risques pour établir un modèle d’affaires viable. Nous avons déjà cité l’article d’Euler datant de 1767 qui traite du calcul des rentes viagères. La généralisation des tables de mortalité date des années 1860. Les calculs actuariels dans l’assurance aux biens n’arrivent que plus tard, au début du xxe siècle. La modélisation a donc commencé par s’intéresser aux risques en eux-mêmes. Dans une évolution naturelle, les actuaires se sont penchés sur l’agrégation de ces risques dans un portefeuille. C’est d’ailleurs à un actuaire italien, Bruno de Finetti, que l’on doit dès les années 1940 le premier développement de la théorie de l’optimisation des portefeuilles (de Finetti, 1940). Cette théorie fera la fortune de Harry Markowitz dans les années 1950-1960 lorsqu’il l’appliquera au domaine des investissements financiers avec son idée de fron-tière efficiente (Markowitz, 1952). Ces premières générations de modèles qui avaient surtout pour but de calculer des primes pour les contrats ont petit à petit permis l’émergence de modèles intégrant tous les risques pour produire une évaluation du capital nécessaire à la conduite des affaires. Cette évolution s’est faite parallèlement à celle des banques et aux premiers efforts du Comité de Bâle pour mettre en place une réglementation bancaire basée sur les risques. Le début du xxie a été marqué par les modèles de dynamic finan-cial analysis (DFA) (Blum et Dacorogna, 2004) qui avaient pour but de déterminer le risque de la compagnie à travers une modéli-sation du bilan comptable et la détermination de la mesure de risque (VaR ou TVaR) liée au changement de la valeur comptable de la compagnie.

Sur le schéma 2, nous montrons cette évolution qui est présentée en quatre générations de modèles. Aujourd’hui, les assureurs attribuent des buts plus ambitieux à la quatrième génération de modèles. Ils veulent que ces derniers leur permettent de générer plus de valeur dans leurs affaires en optimisant le portefeuille actifs-passifs, en examinant les bénéfices de diversification des différents types d’affaires, en optimisant les couvertures de réassurance pour réduire le coût du capital, en planifiant de manière plus quantitative le développement des activités de la compagnie. Toutes ces applications vont bien au-delà des simples exigences de solvabilité. Elles requièrent la connaissance de toute la distribution de probabilités des changements de la valeur économique de l’entreprise. Nous avons illustré cela par une distribution comme produit final de la quatrième génération de modèles du schéma 2. On doit donc pouvoir avec ces modèles répondre à la question : quelle est la probabilité d’atteindre les objectifs fixés ? Pas seulement quel est le risque à une fréquence d’une fois tous les deux cents ans ! Il est d’ailleurs paradoxal que l’on se soit d’abord concentré sur les extrêmes où, par définition, les données manquent et que l’on ait négligé le centre de la distribution où les données sont plus abondantes. Les assureurs les plus modernes font donc usage de l’ensemble de la palette de données qui s’est d’ailleurs renforcée avec l’avènement du big data4 et des possibilités que ces données offrent pour affiner l’offre de couverture et optimiser le calcul des primes.

Outre l’accès aux données, l’organisation autour du modèle joue un rôle de plus en plus important avec la mise en place de la nouvelle réglementation. Il faut en effet s’assurer à la fois de la pertinence des données utilisées et des résultats produits par le modèle. Comme pour la production des bilans comptables, des processus plus rigides de contrôle se mettent petit à petit en place. En particulier, la validation du modèle doit, selon la nouvelle réglementation, être effectuée par un organisme indépendant. Les entreprises se tournent donc soit vers des consultants externes, soit développent à l’interne des capacités indépendantes, parallèles à la division de modélisation. Une évolution possible serait de faire auditer les résultats par des cabinets spécialisés. Ce n’est pas encore le cas, mais on voit apparaître sur le marché des consultants qui ambitionnent de jouer ce rôle. Il ne faudrait pas cependant que cette institutionnalisation de la production du modèle interne se fasse au détriment de la flexibilité nécessaire pour adapter les méthodologies aux évolutions de la science et des techniques de programmation. C’est là l’un des dangers qui guettent les compagnies. L’évaluation des risques suppose des connaissances et des qualifications qui vont bien au-delà de celles demandées à la comptabilité. De plus, les résultats du modèle interne n’auront jamais la rigueur et la précision atteintes par les bilans comptables des entreprises. Il s’agit d’estimations statistiques et non de comptage et de classification de cash-flows. Ces estimations, à supposer que le modèle soit parfaitement adéquat, ne seront connues qu’avec une précision de quelques pourcents, ce qui représente plusieurs dizaines voire plusieurs centaines de millions d’euros. Cette situation est difficilement acceptable par une direction habituée à la précision des valeurs comptables. Les autorités de surveillance sont dans le même cas et regardent avec suspicion toutes les variations des chiffres liés au modèle interne. Elles sont pourtant inévitables.

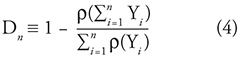

L’un des produits importants du modèle est le bénéfice de diversification, autrement dit la quantité de capital épargné en agrégeant les risques dans le portefeuille. Ce bénéfice est calculé de la façon suivante (Bürgi et al., 2008) :

où la variable aléatoire Yi représente un risque particulier du portefeuille et r représente, comme dans l’équation (3), la mesure de risque choisie (VaR ou TVaR). Notons au passage que cette quantité, même si elle est très intéressante, n’est pas définie de manière universelle : elle dépendra du nombre de risques considérés dans le calcul. C’est pourquoi nous l’avons définie avec un indice n dans l’équation (5). Dans le tableau, nous montrons un exemple de ce bénéfice tel qu’il a été rapporté par SCOR lors de sa journée d’information aux investisseurs de juillet 2009 (SCOR, 2009). Ces chiffres, même s’ils sont datés, illustrent bien l’intérêt de pouvoir examiner le bénéfice de diversification obtenu par le groupe lorsqu’il calcule son capital en intégrant tous les risques. On voit, par exemple, que dans le cas d’un réassureur, les investissements ne représentent qu’une petite portion du risque lorsqu’ils sont rapportés au portefeuille alors que leur capital individuel se monte à plus de la moitié du capital individuel des affaires vie du groupe. Au final, lorsqu’on considère ces grandes lignes d’affaires, le groupe atteint un bénéfice de diversification de 47 %, ce qui est considérable. D’autres réassureurs publient des chiffres similaires. Le bénéfice de diversification est essentiel pour la bonne marche de ce genre d’affaires (Boller et Dacorogna, 2004). Les réassureurs apportent donc un soin particulier à la modélisation de leurs portefeuilles.

Pour terminer cette brève incursion dans le monde du modèle interne, mentionnons qu’il existe au moins trois types d’évaluations quantitatives des risques d’assurance :

- les modèles de type stochastique basés sur des distributions de probabilités et une modélisation plus ou moins sophistiquée de la dépendance entre les risques ; généralement, les modèles internes des compagnies appartiennent à cette catégorie ;

- les modèles de type déterministe ou modèles à facteurs ; le capital est calculé à partir d’une mesure du volume d’affaires que l’on multiplie par un facteur (souvent appelé « intensité du capital ») ; ces modèles sont typiquement utilisés par des agences de notation pour estimer le capital nécessaire aux entreprises qu’elles examinent ;

- les modèles basés sur des scénarios ; plusieurs scénarios sont appliqués au bilan économique pour examiner la valeur de la compagnie soumise à différents états du monde ; ces modèles aussi parfois appelés « tests de stress » ont été appliqués par la Federal Reserve américaine aux banques américaines en mars 2009 ; les résultats positifs ont permis de rétablir la confiance des marchés.

La plupart des entreprises utilisent un mélange de ces approches. Si les modèles déterministes sont favorisés parce qu’ils sont simples d’utilisation et donnent des réponses quasi instantanées aux questions posées, ils souffrent d’un manque de flexibilité. En effet, les facteurs déterminés dans certaines situations risquent de ne plus l'être dans d’autres circonstances ou si le portefeuille de l’assureur change considérablement. Les deux autres types sont, au fond, équivalents. Les modèles stochastiques permettent d’explorer un grand nombre de scénarios avec une grande efficacité ; par contre, les scénarios qu’ils génèrent sont rarement identifiables et compréhensibles à leurs utilisateurs. Les scénarios appliqués au bilan économique sont plus intuitifs car ils sont soit tirés de valeurs historiques, soit construits à partir de visions stratégiques sur un possible état du monde dans le futur. Dans la pratique, ces scénarios sont souvent utilisés pour vérifier la plausibilité des résultats obtenus par les modèles stochastiques. C’est ainsi qu’ils sont utilisés par la Finma qui demande aux assureurs de fournir les résultats de six scénarios en plus de ceux du modèle interne. Pour plus de détails sur le sujet des modèles internes et de leurs développements, le lecteur intéressé pourra se référer à Dacorogna (2009).

L’estimation quantitative des risques d’entreprise joue un rôle de plus en plus central et nous avons vu qu’elle s’intègre toujours plus aux autres processus de l’organisation. Elle permet d’augmenter la perception du risque dans l’ensemble de la compagnie. En même temps, elle devient un guide à la décision des choix stratégiques et permet de faciliter les discussions sensées autour des grands enjeux. Il ne s’agit pas de suivre aveuglément les résultats des modèles, mais la décision de s’en écarter devra être fondée sur de solides arguments pour qu’elle soit prise. C’est pourquoi les assureurs y ont de plus en plus recours et que nous assistons à l’évolution vers des systèmes de plus en plus industrialisés et intégrés à la vie des entreprises.

La gestion intégrée des risques

Nous terminerons ce tour d’horizon des changements fondamentaux qui se produisent dans le monde de l’assurance à la faveur de l’implémentation des nouvelles règles de solvabilité par la question, toujours plus actuelle, de la gestion intégrée des risques souvent désignée sous son acronyme anglosaxon d’ERM (enterprise risk management). La gestion des risques a été longtemps considérée comme le domaine spécifique du directeur des risques et de sa petite équipe. Celui-ci devait s’assurer que l’organisation ne s’exposait pas trop et que les limites assignées étaient respectées. Chacun travaillant en silo, le directeur des risques devait contrôler que la somme des parties ne dépassait pas la capacité du tout. La plupart du temps, il rapportait au directeur financier (c’est encore le cas dans un certain nombre d’entreprises). Cependant, la prise de conscience que le risque est l’objet même des affaires d’assurance change complètement la perspective : gérer le risque devient une gestion pérenne de l’assurance et s’inscrit directement dans les tâches du directeur général, mais aussi des directions opérationnelles. Dans les entreprises les plus avancées, la direction des risques rapporte directement au directeur général et l’on trouve dans les conseils d’administration à côté du comité stratégique, du comité d’audit ou des rémunérations, un comité des risques auquel le directeur des risques doit directement rendre des comptes. Ces changements organisationnels sont le reflet de la nouvelle compréhension que la gestion des risques est centrale pour la bonne marche des affaires.

La gestion intégrée des risques part du présupposé qu’à chaque rendement est lié un risque et que les deux doivent être en proportion. Plus le risque est élevé, plus le rendement doit l'être, et inversement. Le capital de la compagnie étant limité, il doit être utilisé de façon à générer le maximum de profit tout en assurant la stabilité financière de l’entreprise. Il s’agit de trouver le point d’équilibre entre la solvabilité, la profitabilité et le développement des affaires. Ainsi, gérer le risque revient à gérer aussi le rendement de la compagnie. Le directeur des risques n’est plus l’empêcheur de tourner en rond, mais le facilitateur des affaires, celui qui permettra un développement continu commensurable avec les capacités de l’entreprise et les spécificités des marchés. Quel changement de perspective !

Tout cela implique donc l’approfondissement et la généralisation d’une culture du risque à toute l’organisation. L’ERM concerne tout le monde dans l’entreprise. Chacun doit être conscient de son rôle et connaître les règles de gestion des risques qui ont été approuvées par la direction de l’entreprise. Ces règles auront pour objet :

- la définition claire des domaines de risques que la compagnie veut voir dans son portefeuille, son appétit au risque ;

- la délimitation précise de sa tolérance au risque telle qu’elle peut être déduite des exigences des différentes parties prenantes (actionnaires, clients/régulateurs, agences de notation et direction de l’entreprise) ;

- une vision claire du profil de risque déduite des deux précédents ;

- l’établissement de limites précises pour chaque risque individuel telles qu’elles peuvent être déduites des trois éléments précédents : l’appétit au risque, la tolérance au risque et le profil de risque.

Pour permettre l’établissement d’une telle culture, il faut que ces différents éléments soient explicites dans une série de documents disponibles à tout un chacun dans l’entreprise, mais aussi communiqués à toutes les parties prenantes. Il s’agit en quelque sorte des règles du jeu que la compagnie se donne et fait connaître chez elle et autour d’elle.

Cela suppose bien sûr une structure de gouvernance efficace et profondément enracinée dans l’organisation. Nous avons vu plus haut quels changements sont en train de se produire pour placer la gestion du risque au centre de la structure. Le rôle du conseil d’administration, en tant que représentant des actionnaires, sera le garant de l’établissement d’un appétit au risque clair ainsi que d’un profil associé. C’est lui qui fixe avec le concours de la direction générale la tolérance au risque et s’assure que ces informations soient bien comprises dans l’organisation. Cela implique une grande transparence dans les rapports hiérarchiques concernant ces points, mais aussi l’établissement de rapports réguliers des échelons inférieurs vers la direction et le conseil d’administration.

Pour bien comprendre cela, nous allons l’illustrer avec un exemple concret tiré de notre pratique. L’établissement d’une stratégie d’investissement d’une assurance est un processus complexe qui implique plusieurs secteurs de l’organisation. Le conseil d’administration et le comité exécutif fixent les limites en termes de capital à ne pas dépasser. Par exemple, les investissements ne doivent pas consommer plus de 20 % du capital alloué au risque de la compagnie. La limite ainsi déterminée, le comité exécutif décide quelle portion effective de ce capital il alloue, disons 10 %. C’est ensuite au comité des investissements de déterminer l’allocation effective de ce capital aux différentes classes d’actifs en fonction de la gestion actifs/passifs qui aura déterminé la duration du portefeuille d’obligations pour immuniser les fluctuations des réserves dues aux taux d’intérêt, la proportion des différents types d’actifs risqués pour optimiser le rendement du portefeuille d’investissements, sans dépasser les limites assignées. Sur cette base, les gestionnaires, qui effectueront les transactions dans le marché, reçoivent un budget qu’ils doivent optimiser au mieux. On voit dans cet exemple que c’est en fait tous les niveaux de l’entreprise qui sont concernés par la démarche et seule une communication dans les deux sens permettra une exécution et un contrôle effectif de la stratégie.

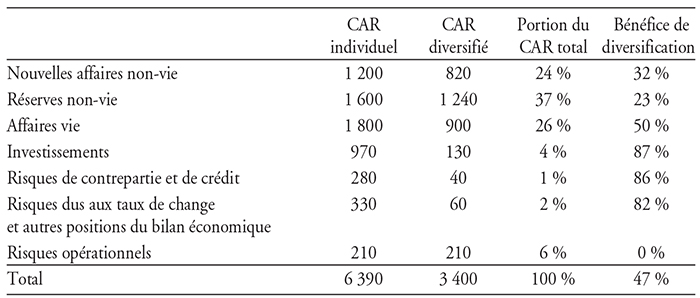

Sur le schéma 3, nous illustrons cette transparence nécessaire et déclinons les différentes responsabilités pour un bon fonctionnement de la gestion des risques et la correction des processus opérationnels défectueux. On voit bien que la culture du risque doit être largement répandue dans l’organisation avec des systèmes de retour d’information à tous les niveaux. C’est sur cette base que peut se construire une gestion intégrée des risques dont les trois piliers seront :

- l’évaluation quantitative des risques sur la base d’une modélisation du portefeuille de la compagnie ;

- la veille et la gestion des risques émergents ;

- le développement de processus de contrôle et de signalisation des risques.

Nous avons amplement discuté le premier pilier dans la partie précédente. Le deuxième pilier constitue une mission nécessaire de la direction des risques pour éviter que l’entreprise ne soit prise au dépourvu par l’émergence d’un risque dévastateur, comme la découverte des conséquences de l’utilisation de l’amiante ou le changement de la législation française concernant le remboursement des accidents de voiture, passant à un système de rentes au lieu d’une somme allouée comme dédommagement. Il s’agit d’organiser au sein des différents départements une veille continuelle qui permette d’identifier les risques potentiels, de les évaluer et de proposer des moyens d’en atténuer les conséquences. Pour la première mission, on utilisera aussi bien les ressources internes que toutes les sources externes possibles. Pour donner un exemple de ces ressources externes, il existe, par exemple, une compagnie aux États-Unis qui digitalise tous les articles scientifiques en chimie et biologie (plus de 50 000 par an !) pour y chercher l’apparition fréquente du nom de certaines substances. Ils interprètent cela comme un signe que l’on est en train de découvrir des effets secondaires à ces substances. L’évaluation des conséquences de l’apparition de ces risques implique toutes les parties concernées dans l’organisation y compris le département de finance pour examiner l’impact financier et étudier les possibilités de couverture. Les mesures à prendre en cas d’identification d’un tel risque sont de différents ordres : recherche de stratégie de couverture auprès des réassureurs ou sur les marchés financiers, imposition de nouvelles limites à la souscription, changement des contrats d’assurance et, en dernière ressource, sécurisation de l’accès à de la liquidité, par exemple, à travers des contrats de capital contingent. Pour terminer ce bref rappel des mesures à prendre pour une bonne préparation aux risques émergents, il faut encore mentionner l’importance de tirer les leçons de ceux qui sont apparus en mettant en place des procédures spécifiques pour cela.

Le troisième pilier de la gestion intégrée sera bien sûr les processus de contrôle et d’information qui doivent être présents à tous les niveaux. Il s’agit d’identifier, de prioriser et de contrôler les sources possibles de risques. Nous en avons déjà parlé à propos de l’importance de l’existence de règles précises et écrites qui doivent être connues dans l’ensemble de l’organisation. Il faut ajouter que ces règles doivent aussi comporter des procédures claires sur les conséquences encourues si elles ne sont pas suivies. Tout cela n’aurait pas de sens sans l’existence de processus réguliers de mesure de l’application des limites. Ici, le modèle interne représente un outil précieux puisqu’il concentre toutes les données du portefeuille, mais il ne suffit pas. Des outils de contrôle de l’accumulation de l’exposition aux risques sont des compléments indispensables. Les grands réassureurs, par exemple, ont tous développé des plates-formes informatiques pour contrôler leur exposition aux catastrophes naturelles. Elles permettent de comparer le volume des affaires aux limites fixées et de produire des rapports qui seront utilisés dans le tableau de bord que la direction des risques produit chaque trimestre pour les comités des risques du groupe et du conseil d’administration. Le tableau de bord, un court rapport de quelques pages avec des images permettant de visualiser rapidement les problèmes, est un instrument indispensable pour communiquer au niveau de la direction. Le but est de produire régulièrement un état des lieux rapidement accessible. L’effort de produire ce rapport synthétique permet une mobilisation de l’ensemble des structures du groupe pour une réflexion sur les points cruciaux.

La réglementation européenne avec Solvency II et, bientôt, la réglementation américaine ont mis en avant l’ORSA (own risk and solvency assessment) pour complémenter l’évaluation quantitative des risques. Il s’agit de développer des rapports parallèles aux bilans comptables et économiques qui feront en quelque sorte le bilan des risques de la compagnie et identifieront les forces et les faiblesses de l’entreprise dans ce domaine. L’ORSA devient un élément important du reporting des entreprises et s’intègre parfaitement dans le troisième pilier de la gestion intégrée des risques.

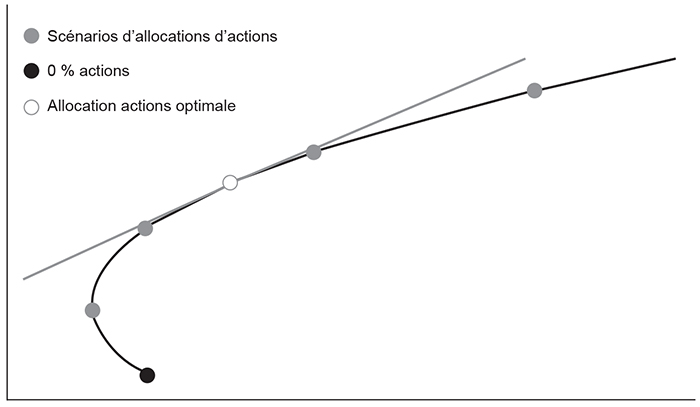

La culture de gestion des risques et les trois piliers constituent le substrat qui rend possible la gestion stratégique des risques. Nous l’avons déjà souligné, cette gestion se concentre sur le binôme risque/rendement et cherche à optimiser le portefeuille dans ce sens. Un exemple de cette gestion est montré sur le graphique 2 (ci-contre). On y a représenté la frontière efficiente du portefeuille en fonction de la mesure de risque considéré (ici TVaR) et de la composition du portefeuille d’actifs de la compagnie. On veut ici déterminer l’allocation stratégique des actifs. Cette frontière est construite à partir de la modélisation de l’ensemble du portefeuille (actifs et passifs) où l’on fait varier la proportion de l’investissement en actions de 0 % à 25 %. On voit qu’un portefeuille ne contenant que des obligations (premier point à gauche de la courbe) ne serait pas sur la frontière. On atteindra le minimum de risque avec 5 % d’actions dans le portefeuille. Ce sera donc la limite basse de l’allocation stratégique. La limite haute sera fixée par le capital-risque maximum autorisé qui se situe ici autour de 16 %. Le point optimum sera obtenu au point de contact entre la tangente, dont la pente sera égale à l’objectif de profit de la compagnie, et la courbe de la frontière efficiente, ici 12 %. L’allocation stratégique en actions se fera donc entre 5 % et 16 % avec une allocation optimale autour de 12 %. Le comité d’investissement aura alors la tâche de fixer son allocation tactique dans ces marges en fonction de ces indications stratégiques. On voit ici l’importance d’une bonne quantification des risques et l’utilité du modèle interne couplé à un processus clair pour définir l’allocation stratégique. On est loin ici des discussions que les anciennes instances dirigeantes avaient sur l’allocation en actions du portefeuille. Le capital et son utilisation deviennent le centre de la discussion et permettent d’évaluer les différentes propositions d’affaires à partir de cette métrique. Le but même de la gestion intégrée des risques est d’arriver à une utilisation optimale du capital à la disposition de la compagnie pour obtenir le rendement fixé dans les objectifs de l’entreprise.

On voit donc que l’ERM n’est rien d’autre, au fond, qu’une pratique conséquente du métier d’assureur : elle affecte l’organisation dans son ensemble, permet de mettre en évidence les générateurs de valeur dans l’assurance, donne une mesure de la performance des affaires et contribue à rendre l’entreprise plus transparente pour toutes les parties prenantes. Ce n’est donc pas qu’une mode éphémère à laquelle les compagnies se plient, mais la gestion intégrée des risques devient la manière d’approcher les affaires de façon plus professionnelle. Elle formera donc l’ossature de l’assurance du futur. Elle exige un engagement à long terme de toutes les structures de la compagnie pour atteindre l’excellence. Aristote disait : « L’excellence est un art que l’on n’atteint que par l’exercice constant. Nous sommes ce que nous faisons de manière répétée. L’excellence n’est donc pas une action, mais une habitude. » Cette maxime exprime une sagesse qui s’applique totalement à l’ERM.

Conclusion

Nous arrivons au terme de ce panorama des changements que vivent les compagnies d’assurances avec l’implémentation de Solvency II. Cette évolution a été favorisée par l’avènement de la nouvelle directive, mais elle avait en fait commencé bien avant sous la pression des marchés financiers et de la libéralisation des marchés de capitaux et de l’assurance. Les exigences sociales de protection et de sécurité amènent les compagnies à réfléchir sur la meilleure façon d’offrir des services de qualité au meilleur prix aux consommateurs et se voient dans l’obligation d’adapter leurs pratiques. La crise financière de 2008-2009 a montré l’importance de relier la performance aux risques. La résilience des sociétés d’assurances durant cette période est aussi un témoignage de l’avènement d’une gestion des risques plus conséquente de la part d’institutions confrontées depuis toujours aux risques extrêmes.

Dans l’assurance, nous passons de la gestion des flux à la gestion des risques et du capital. Cela implique un engagement de long terme et, nous l’avons vu, une réorganisation fondamentale des structures des compagnies. L’approche quantitative prend de plus en plus d’importance. Le rôle des actuaires passe des coulisses à la scène. Ils se retrouvent en première ligne et sont amenés à répondre aux questions stratégiques fondamentales des entreprises. Les modèles internes, les systèmes informatiques complexes pour traiter de grandes quantités de données deviennent des activités centrales. Comme dans les banques, l’industrialisation des activités quantitatives est partout à l’ordre du jour. Parallèlement à la production de bilans comptables, on passera à la production et la publication de bilans économiques et de bilans des risques avec l’ORSA et le troisième pilier de Solvency II. Cette pratique devrait favoriser la transparence et la discipline de marché.

Les limites et les controverses autour de l’application de ces nouvelles normes sont nombreuses. Nous en avons évoqué certaines dans cet article. Beaucoup sont liées à l’adaptation des valorisations financières, conçues initialement pour des instruments financiers à court terme, aux conditions des contrats d’assurance qui sont, par définition, des engagements de long terme, surtout dans l’assurance-vie. Quels risques faut-il attribuer au temps ? Et par conséquent, combien de capital faut-il lui allouer ? Cette question reste largement inexplorée et devra trouver dans le futur une réponse théorique satisfaisante pour résoudre beaucoup de problèmes qui se posent encore. Néanmoins, les avantages de l’approche de valorisation économique l’emportant largement sur ses limites. Il est clair que cette approche prendra le pas sur les autres et que l’on ne reviendra pas en arrière. La gestion intégrée des risques fera bientôt partie de l’ADN des assureurs. Le chemin reste long et plein d’obstacles, mais la direction est déjà prise.