« Une bonne politique industrielle se focalise

sur le renforcement du flux de savoir-faire entrepreneurial…

En pratique, ceci implique de préparer la force de travail à gérer

et à surmonter

les changements profonds appelés par la digitalisation de l'économie1. »

Christophe Schmidt

Président du Conseil allemand des experts économiques

Directeur de l'Institut économique Leibniz, Essen

Fidélisation des actifs sous gestion

Depuis la Grande Récession de 2008, le paysage de la banque privée européenne s'est profondément modifié. La concurrence d'acteurs non européens, le plus souvent asiatiques, s'est engouffrée à la faveur des difficultés qu'ont alors connues en Europe occidentale les banques privées ou les départements spécialisés des grandes banques universelles2. De plus, des acteurs purement FinTech tel Revolut, N26 et d'autres encore – nous reviendrons sur ce point à la fin de la seconde partie – sont venus grignoter des parts de marchés non seulement aux banques de détail, mais également aux banques privées traditionnelles. Cet accroissement de la pression concurrentielle s'est conjugué avec la disparition quasi complète des paradis fiscaux et du secret bancaire, qui a affecté une partie de la profession. La croissance des montants sous gestion s'est nettement ralentie, en partie sous l'effet des facteurs que l'on vient d'évoquer, en partie aussi par le ralentissement des valorisations boursières. Surtout, l'évolution de ces montants est devenue plus volatile, affectant par là même la profitabilité du secteur. C'est à cet aspect spécifique que cet article va s'attacher et proposer une gestion proactive de ce risque-client d'une ampleur nouvelle.

La volatilité des actifs sous gestion ne s'est pas limitée au grand ralentissement conjoncturel de la fin des années 2000, ni à des événements politiques tels la fermeture de paradis fiscaux, l'abrogation du secret bancaire, ou encore la guerre commerciale États-Unis-Chine. Bien au contraire, la véritable importance de cette volatilité tient à ce qu'elle s'est installée de façon quasi permanente et affecte périodiquement les résultats de nombre d'acteurs du secteur. Au quatrième trimestre 2018, UBS a ainsi enregistré le retrait de 8 Md$ d'actifs sous gestion, Julius Baer de 13 MdCHF3, alors que le début d'année avait enregistré des entrées nettes de fonds. C'est ainsi que les profits réalisés par l'ensemble des banques privées d'Europe, qui avaient fini par retrouver en 2015 le niveau atteint avant la crise de 2008, ont baissé de près de 10 % en 2016, avant d'atteindre en 2017 un nouveau pic et de retomber ensuite4. Des mouvements similaires ont affecté la plupart des autres acteurs de la gestion de fortune en Europe et en Israël, où l'attraction des multi-family offices s'est particulièrement fait sentir pour mieux conserver la personnalisation des portefeuilles, sacrifiée dans certaines grandes et moyennes banques à une rationalisation des coûts excessive et à une application inadéquate de la réglementation, comme on le montrera infra.

Face à cette incertitude d'un nouveau type, les banques privées peuvent avoir recours à quatre stratégies :

-

une première stratégie consiste, lorsque cela s'avère possible, à acquérir des acteurs apportant synergie et taille à l'établissement, soit en Europe, soit sur d'autres continents, Amérique Latine, Émirats du Golfe ou Amérique Centrale notamment. L'évolution des dix dernières années a en effet montré que la taille, mesurée par le montant des actifs sous gestion, favorise, toutes choses égales par ailleurs, l'acquisition d'actifs supplémentaires (au-dessus de 30 Md€, le facteur d'attraction est double par rapport aux acteurs disposant de moins de 10 Md€, et il est supérieur pour les banques plus importantes) (McKinsey, 2017). Cette stratégie est loin de toujours permettre à la banque de contrebalancer les multi-family offices développés dans la période récente ;

-

une deuxième réaction vise à diminuer les coûts autant que possible, ce que les banques ont réussi à faire ces dernières années – quoique parfois de façon trop brutale – malgré l'augmentation des coûts de mise en conformité dus à MIFID-II ;

-

aux fonds sous mandat contractuel, les banques ont, en troisième lieu, cherché à substituer de plus en plus de fonds sous gestion discrétionnaire, ainsi que des fonds sous gestion conseillée, cherchant à adapter leur intervention à la situation de chaque client. Pour ces deux derniers types d'intervention, les marges sont en effet plus importantes. Cela a joué comme une compensation partielle à l'interdiction des rétrocessions depuis MIFID-II. Il est important de noter que cette stratégie dispose encore d'un grand gisement de ressources en Europe, puisqu'on dénombrait seulement, à la fin de 2017, 27 % des fonds en gestion discrétionnaire et 18 % en gestion conseillée (McKinsey, 2018). Ce glissement dans l'organisation du métier de gérant de fortune – banque privée ou département spécialisé de grande banque universelle – constitue une véritable revalorisation du métier. Celle-ci se conjugue avec la relégation d'une bonne partie des tâches dites de back-office à des systèmes automatiques et avec l'utilisation de la puissance de mise en contact du numérique pour permettre une gestion de banque « ouverte » de type e-banking, assurant un grand confort au client5. Le gérant de fortune dispose ainsi de beaucoup plus de latitude pour assurer une bonne communication de la politique d'investissement de la banque dans les mandats discrétionnaires. Il peut également se consacrer entièrement à sa mission de conseil en produits financiers selon les souhaits des clients dans le cadre de mandats de conseil. On aborde ainsi une quatrième stratégie possible ;

-

c'est en effet par une offensive numérique allant au-delà de la simple commodité de communication des informations disponibles à laquelle on vient de faire allusion, aujourd'hui admise dans une bonne partie de la profession, que le quartile supérieur des banques privées enregistrant les meilleures performances est caractérisé (McKinsey, 2017 et 2018). Il s'agit en effet pour cette frange d'acteurs-leaders d'utiliser la digitalisation pour amplifier leur capacité cognitive de conseil de gestion en s'appuyant sur la production d'informations précises dont on ne disposait pas auparavant. Cette quatrième stratégie dispose elle aussi d'un potentiel considérable. En effet, contrairement à une opinion largement répandue dans la profession, certains parmi les mixed robots advisors ou conseillers robots mixtes peuvent fournir aux gérants de fortune davantage d'instruments et de ressources pour mieux servir leurs clients et prendre plus finement en compte les préférences de ces derniers en matière d'investissements financiers, comme on l'argumentera en seconde partie de cet article. Dans certains cas, pour les clients UHNW, la banque peut créer de véritables family offices en interne pour réagir aux tendances déjà évoquées.

Avant de se pencher sur les troisième et quatrième stratégies sous l'angle de la gestion du risque-client, on est en droit de se demander pourquoi MIFID-II, animée des meilleures intentions en matière de protection et de connaissance du client investisseur de détail, n'a pas jusqu'ici poussé les acteurs du marché à se rapprocher de ces stratégies de façon innovante. La notion d'adéquation-client développée dans l'article 25 de MIFID-II aurait pu en effet être au moins une inspiration pour gérer le risque-client.

Rappelons les éléments essentiels ici : la Directive 2014/65 du 15 mai 2014 de l'Union européenne, dite MIFID-II, a introduit dans son article 25 des dispositions visant à garantir la protection des investisseurs dits « de détail », par opposition aux clients professionnels : lorsqu'une institution financière ne se contente pas de recevoir, transmettre et exécuter les ordres passés par des clients, mais fournit effectivement des conseils en investissement ou en gestion de portefeuille à des clients, elle doit s'informer préalablement à toute recommandation pour recueillir :

a) l'expérience du client sur les supports ou produits financiers proposés ;

b) les connaissances du client sur les supports ou produits financiers proposés ;

c) la situation financière du client ;

d) la capacité spécifique du client à supporter des pertes ;

e) l'objectif de l'investissement envisagé ;

f) la tolérance au risque spécifique du client.

Ces informations portent sur des éléments de nature diverse. On voit en effet que les deux premiers éléments (a et b) ne peuvent résulter que de déclarations de la part du client et le second élément doit d'ailleurs faire l'objet de vérifications de la part de la banque, comme l'ont précisé les « lignes directrices d'application de l'article 25 de MIFID-II » formulées le 28 mai 2018 par l'Autorité européenne des marchés financiers (AEMF ou ESMA – European Securities and Markets Authority).

Les deux éléments suivants (c et d) s'appuient en revanche sur des données factuelles, quasi automatiquement vérifiables par la banque. La capacité à subir des risques est en effet un élément appuyé sur les données « objectives » de la situation financière de l'investisseur et sur un jugement de sens commun, formulé par la banque, mais rencontrant souvent l'approbation du client. C'est dans les cas où cette approbation fait défaut que le jugement de sens commun prend une importance décisive pour la protection de l'investisseur. La Financial Conduct Authority (FCA, précédemment FSA – Financial Services Authority) y avait vivement insisté (FSA, 2011), avant même l'entrée en vigueur de MIFID-II, comme le fait aujourd'hui le document de ESMA (2018).

Les deux derniers éléments (e et f) relèvent respectivement de l'intention personnelle déclarée par le client et de caractéristiques subjectives de l'investisseur.

Le texte souligne de façon très explicite que la banque doit en particulier vérifier que les recommandations adressées au client sont bien adaptées à la « tolérance au risque » et à la capacité à subir des pertes du client6. C'est cette conjugaison d'éléments « subjectifs », d'une part, et d'éléments « objectifs », d'autre part, qui fondent l'« adéquation » (suitability) de la recommandation formulée par la banque et qui constitue le « profil de risque » à proprement parler de l'investisseur. L'article 25 de MIFID-II précise avec insistance que la tolérance au risque doit être évaluée de façon explicite. Dès lors, cette dernière aurait-elle pu constituer une base pour une gestion du risque-client ?

Nous serons conduits, dans une première partie, à examiner la mise en œuvre souvent décevante, sous cet angle de l'adéquation, de la réforme MIFID-II. Non seulement la conformité véritable de beaucoup de banques à l'article 25 est à mettre en question, mais aussi la mise en œuvre choisie n'a pas pu amorcer de gestion du risque-client. Il nous faudra donc montrer, dans une seconde partie, pourquoi établir un lien entre adéquation-client et gestion du risque-client s'avère à la fois profitable pour la banque et satisfaisant pour le régulateur. Nous montrons qu'un tel lien peut conduire à un aggiornamento qui serait un véritable « bien commun » pour l'ensemble de la profession.

Une mise en œuvre souvent décevante

de l'impératif d'adéquation-client

Ce que suggère au premier abord la lecture de l'article cité de MIFID-II est que son application devrait doter la banque d'une base de données sérieuse pour gérer le risque-client. L'observation amène cependant à se départir d'un tel optimisme. On peut trouver deux raisons essentielles à ce qu'il faut bien considérer comme un échec de MIFID-II sur le plan de l'adéquation-client : une mise en œuvre a minima et le recours à des méthodologies très insuffisantes, induisant fréquemment des erreurs dommageables à tous.

La vision de conformation minimale

La culture financière classique ne met l'accent que sur les mesures objectivement observables sur un marché, qu'il s'agisse de prix, de volume échangé ou de volatilité. De ce fait probablement, beaucoup de professionnels de la gestion de fortune n'acceptent qu'avec beaucoup de réticence l'idée même de mesurer les aspects psychologiques ou plus généralement subjectifs des comportements individuels. Cette réticence à prendre en compte les aspects psychologiques – malgré l'intérêt indéniable soulevé par la finance comportementale, hélas limitée pour l'essentiel à des études sans application au risque-client7 – devient incrédulité dès lors qu'il s'agit de saisir cet insaisissable qu'est une « tolérance » ou une « aversion » au risque. Peut-on en effet définir de façon précise de telles variables ? C'est aller au-delà de la capacité objectivement repérable (en fonction de la fortune, du montant de l'investissement souhaité, etc.) d'un investisseur à supporter des montants de pertes possibles – un indicateur précieux et auquel il ne s'agit surtout pas de déroger, mais qui n'est pas la tolérance visée à l'article 25 de MIFID-II. La réglementation exprimée dans cet article continue d'être perçue par les professionnels plus ou moins explicitement comme le produit de visionnaires hors de la vie pratique, alors même que les mesures scientifiquement fondées de la tolérance au risque individuelle remontent à quelque cinquante ans.

Dès lors, la banque fera au mieux pour satisfaire à d'éventuels contrôles, mais sans vraiment ajouter foi à la démarche comme outil opérationnel. C'est le plus souvent l'esprit des « questionnaires » que le conseiller remplit en présence du client et que l'on classe ensuite.

Une anecdote illustrera la situation actuelle. Une cliente d'une banque internationalement connue hérite de ses parents. Elle se rend à son agence bancaire. Sa conseillère lui demande de répondre à un « questionnaire informatique », donnant lieu à un score pour chaque réponse fournie, noté sur une feuille de calcul de progiciel présentée comme un « logiciel ». La cliente est ensuite priée de bien vouloir signer les conclusions ainsi déduites des réponses fournies. Il lui est indiqué que son profil de risque correspond à 4 sur une échelle de 5 (échelle allant de défensif (1) à agressif (5)). La cliente rentre chez elle et croise l'un de ses proches, au fait de l'analyse du risque. Elle s'ouvre à celui-ci du résultat du questionnement qu'elle vient de subir et s'entend répondre qu'elle n'a manifestement pas une telle tolérance au risque et qu'elle ferait bien de faire vérifier s'il n'y a pas eu erreur de la part de la conseillère bancaire. Cela pourra lui éviter d'être ultérieurement dépitée voire effrayée des résultats de son placement. Quelques jours plus tard, la cliente suit cette recommandation et retourne à son agence bancaire. Elle s'entend alors répondre par la conseillère de ne surtout pas s'inquiéter, le document qu'on lui a fait signer n'est là que pour attester de la conformité à la réglementation « mais on ne s'en sert pas » (sic). En cas de divergence profil-volatilité, la tâche administrative se résumera bien souvent à refaire un profil de risque à la cliente qui corresponde aux investissements qu'elle souhaite effectivement ! Des observations similaires nombreuses confirment le fait.

Cette vision des choses a abouti à un changement net des pratiques bancaires constatées, mais qui ne va pas dans le sens souhaité par MIFID-II. En effet, il y a une vingtaine d'années, on pouvait observer dans des cas similaires des recommandations très variables d'une banque à une autre, ce qui donnait lieu pour le moins à des sarcasmes8 de la part de clients. Depuis l'introduction de MIFID-II, on observe plutôt des recommandations invariablement « moyennes », s'écartant peu de ce que l'investisseur-tout-le-monde aura du mal à juger critiquable ou inacceptable9…

Du point de vue du client, en effet, la démarche proposée par la plupart des banques s'apparente à un questionnaire à choix multiple imposé et plus ou moins compréhensible pour le client. En pratique, la plupart des clients ont tendance à répondre de façon similaire aux quelques questions qui sonnent l'alarme dans le cerveau reptilien de l'investisseur (« Si la valeur de vos investissements déclinait fortement, de 10 % ou plus par exemple, quelle serait votre réaction ? »). Du point de vue du professionnel, le peu de confiance dans le résultat des questionnaires administrés à ses clients, dont l'anecdote précédente fournit une illustration, n'implique pas pour autant l'ignorance complète du risque-client, que l'on souhaite donc limiter. Or les alertes de violation de conformité au profil de risque de l'investisseur se déclenchent selon des critères aisément contournables si le client déclare souhaiter davantage de prise de risque : mieux vaut en effet un profil tant soit peu audacieux et un portefeuille conservateur10 que l'inverse pour minimiser les charges administratives, comme on l'a déjà expliqué. Il résulte de cette convergence des points de vue de l'investisseur et du professionnel un écrasement de la diversité des recommandations. On peut donc avancer que la réglementation aura abouti à l'exact contraire de la personnalisation que le régulateur recherchait et que les banques privées devraient effectivement souhaiter, dans l'intérêt de leurs clients comme dans leur propre intérêt. Cette dégradation de la valeur du conseil financier a été mise en avant pour expliquer la désaffection récente pour le marché actions (Arrondel et Masson, 2017). On peut même se demander si la mise en place de la réglementation MIFID II et l'écrasement induit des recommandations par les conseillers financiers n'est pas également responsable de la performance médiocre des portefeuilles de clients de banques privées européennes quand on la compare à la performance globale des marchés financiers (McKinsey, 2017).

Des insuffisances sérieuses de méthode

Ce résultat n'est paradoxal qu'en apparence. La plupart des questionnaires adoptés par les banques ignorent en effet les développements scientifiques de la mesure de la tolérance au risque que l'on rappellera au paragraphe suivant. Surtout, quel qu'en soit le contenu, les questionnaires à questions fixées par avance sont nécessairement dans l'incapacité de fournir ni le profil de risque significatif que demande MIFID-II, ni un profil pertinent pour gérer le risque-client, et ce pour des raisons bien documentées en psychologie comme en économie expérimentale de la décision face au risque. On se bornera ici à évoquer quelques-unes de ces raisons.

1) Un grand nombre de questions dans les questionnaires usuels demandent à l'individu d'évaluer un montant ou une réaction. Par exemple, la question « Pouvez-vous indiquer quel est le niveau de risque associé à un produit dérivé de matières premières ? » représente non seulement une question difficile sur le fond pour un investisseur de détail ou même pour un investisseur avisé et expérimenté, mais aussi exige – c'est le point essentiel à relever ici – une « tâche d'évaluation ». Une question plus simple mais exigeant aussi une tâche d'évaluation serait : « Quelle somme certaine serait équivalente pour vous à un produit vous procurant 5 % de rendement avec 2 chances sur 3 et –4 % avec 1 chance sur 3 ? ». Or l'expérience montre que notre cerveau est très mal organisé pour de telles tâches et conduit à des réponses extrêmement instables, entachées de nombreux biais possibles, relevés depuis longtemps et bien documentés11. Par contraste, des questions portant sur des comparaisons de deux produits financiers stylisés (sous forme de paris à deux résultats alternatifs possibles chacun) donnent des réponses suffisamment robustes12. Par exemple : « Que préférez-vous : a) un placement vous procurant 5 % de rendement dans 65 % des cas et une perte de –4 % dans 35 % des cas, d'une part ; ou bien, d'autre part, un placement vous procurant 7 % de rendement avec 50 % de chances et une perte de –2 % dans 50 % des cas ? »13. La robustesse des résultats est régulièrement confirmée : le même sujet, interrogé à quelques semaines de distance (dans un contexte général maintenu) fournira, dans près de 95 % des cas, une même réponse. Plus généralement, les résultats deviennent alors « reproductibles » et ne peuvent d'ailleurs acquérir de valeur scientifique qu'à cette condition14. Un exemple fascinant est le fameux « Paradoxe d'Allais », proposé à des milliers d'individus au cours de centaines de tests différents par des financiers, des ingénieurs (industrie nucléaire notamment), des académiques (mathématiciens, psychologues, économistes expérimentateurs, etc.), et qui donne toujours des résultats très voisins15.

2) Par la nature même des questionnaires, les interrogations sont exactement les mêmes pour tous les investisseurs, alors qu'il est essentiel de formuler des questions en fonction de la situation et du contexte financier propres à chacun, à la fois pour que ces questions « parlent » aisément et clairement à l'investisseur et pour qu'elles puissent ainsi appeler des réponses significatives, correspondant au comportement effectif de celui-ci. Or il faut pour cela des ajustements que seul un logiciel peut effectuer automatiquement – après quelques questions factuelles de départ – adaptant en outre de façon interactive chaque question à la réponse précédente. Un corollaire de ces remarques est que le profilage de risque ne peut pas avoir de valeur pour toute la durée d'un investissement. On peut d'ailleurs relever que les « Guidelines… » d'ESMA évoquées ci-dessus exigent des mises à jour périodiques, mais le recours à un questionnaire papier rend cela extrêmement compliqué, pour ne pas dire impossible en pratique.

3) Un grand nombre de questions, dans les questionnaires usuels de « profilage de risque », portent sur des notions interprétables à merci par l'investisseur de détail. Par exemple, « Recherchez-vous le rendement ou la croissance de la valeur de vos actifs ? ». Chaque investisseur de détail répondra à la vision qu'il ou elle associe à de telles notions (biais « de disponibilité »), vision que le chargé de clientèle sera dans l'impossibilité de connaître et donc de décoder. C'est ainsi qu'émerge une « illusion de communication » (Budescu et al., 2009). Pour tenter de contourner cette difficulté, certains questionnaires « encadrent » par des indications quantitatives les vocables utilisés, mais les biais se reportent alors sur les intervalles chiffrés (ibid). De façon générale, la perception du risque par les clients varie fortement en fonction de leur éducation financière, souvent de l'historique des avoirs familiaux, ce qui est fréquemment le cas dans les banques privées de renom, qui gèrent les avoirs des familles sur plusieurs générations. Par exemple, il n'est pas rare d'entendre les clients répondre que leur profil de risque est très conservateur, le portefeuille type du bon père de famille qu'ils décrivent étant composé de 100 % d'actions ! Mais les questionnaires standards ne peuvent pas avoir recours à des questions simples, ayant une signification pratique immédiate pour l'investisseur, sans ambiguïté d'interprétations multiples possibles, car il faut alors poser chaque question de façon variable après chaque réponse pour pouvoir en déduire quelque chose, ce qui renvoie encore à une interactivité que l'on ne peut pas établir de façon praticable à partir d'un questionnaire papier.

4) Presque tous les questionnaires que nous avons pu consulter se prêtent à des « réponses stratégiques16 », la personne questionnée n'indiquant alors pas ce qu'elle pense, mais ce qu'elle souhaite répondre à la place pour produire un effet qui lui tient à cœur, lorsque la question s'y prête. Cette observation se distingue de la précédente en ce qu'elle est le résultat d'une intention explicite, non d'une simple interprétation ou vision de la question posée. C'est le cas lorsque la personne questionnée peut découvrir au moins intuitivement quelle réponse de sa part est susceptible de produire tel ou tel effet, soit sur le résultat (qui est alors manipulé par le sujet questionné), soit sur celles ou ceux qui dépouilleront ou sont chargés d'administrer le questionnaire. Par exemple, dans le choix précédemment évoqué entre « rendement » et « croissance », un investisseur pourra souhaiter apparaître comme un bon père de famille – souhaitant transmettre le patrimoine le plus élevé possible à ses légataires – aux yeux de celle ou de celui qui administre le questionnaire – ou aux yeux de ceux qui dépouilleront ledit questionnaire, et répondra pour produire cet effet « croissance ». On peut d'ailleurs noter que dans le cadre du paragraphe précédent, le « biais de représentativité » pourra conduire l'investisseur à se représenter l'idée de « croissance » comme celle d'une prise de risque. La réponse à une telle question est donc indécodable pour le chargé de clientèle ! On arrive ainsi à des erreurs du type de celle rapportée dans l'anecdote précédente. Les résultats du dépouillement du questionnaire n'auront guère de sens. Idéalement, les questions devraient porter sur des réponses dont il sera difficile à la personne questionnée d'imaginer dans quel sens elles pourraient bien pouvoir influer sur les résultats qu'en retirera la banque ou sur l'image qu'il compte donner de sa personnalité. Mais les questionnaires papier se prêtent très difficilement à de telles formulations, car le « brouillage » nécessaire implique un traitement complexe de l'information fournie, malaisé à imaginer pour des questions et des réponses formulées en langage courant.

5) En partie pour essayer, maladroitement, de contourner les difficultés qui viennent d'être évoquées, ou faute de pouvoir envisager un traitement différent, une grande partie des questionnaires utilisés par les banques font correspondre un « score » à chacune des réponses données et déduisent ensuite de l'ensemble des scores (le plus souvent par simple sommation, pondérée ou pas) un « profil de risque ». Ces pratiques n'ont aucun fondement scientifique et ne sont là dans beaucoup de cas que pour donner l'illusion d'un « questionnaire informatique » ou pour se donner bonne conscience à moindre coût.

6) On ne saurait ici entrer dans la discussion détaillée de ces méthodes de scoring, particulièrement insuffisantes en matière de choix économique ou financier. On se bornera ici à mentionner qu'elles ne sont jamais testées par ceux qui les appliquent, même après avoir conduit à des erreurs telles que celle qu'on a rapportée plus haut comme une « anecdote », alors que la portée de cette anecdote est beaucoup plus vaste. La NASA – entité devant traiter des risques de façon régulière s'il en est – s'est livrée à de tels tests, en comparant les résultats de questionnaires posés aux astronautes et techniciens avec ceux de protocoles impliquant des évaluations de probabilité (soit obtenues par questionnement sur des paris binaires simples, soit résultant de simulations de Monte-Carlo). La comparaison est sans appel en faveur des secondes méthodes et conduit à rejeter les méthodes de scoring qualitatif (Hubbard, 2009 ; Hubbard et Evans, 2010). La conclusion s'impose partout, y compris dans un contexte financier.

Il résulte de cette rapide discussion qu'un protocole destiné à extraire une information sur le risque ou la tolérance au risque des individus ne peut pas s'inventer en quelques heures de réflexion ou de discussion conduite en interne ou par un cabinet-conseil externe le plus souvent dépourvu des ressources humaines très spécialisées nécessaires, seules qualifiées pour le faire. Quels que soient ses qualités personnelles ou son niveau de formation dans d'autres matières, tout un chacun ne saurait s'improviser économiste expérimentateur ou psychologue cognitif. L'« élicitation » d'informations sur le risque a fait l'objet d'une littérature scientifique désormais robuste et bien documentée dans les deux disciplines, mais qui n'a pas encore perfusé dans la pratique, ni en finance, ni dans le conseil en management financier. Les résultats scientifiques obtenus ont pourtant donné lieu à des applications rigoureuses dans les domaines de la gestion de projet en avenir risqué, de l'ingénierie de pointe et même du génie civil. Mais ce n'est pas encore le cas dans le domaine spécifique de la mise en œuvre de l'article 25 de MIFID-II pour le wealth management ou le conseil en investissement – quelle que soit l'institution qui prodigue ce conseil, banque privée, compagnie d'assurance ou autre.

Il conviendrait d'ailleurs d'ajouter ici qu'il semble y avoir une hétérogénéité d'un pays à l'autre des traitements par les tribunaux des plaintes déposées par les clients de banques privées à travers l'Europe des vingt-huit. On propose quelques références sur ce point en fin de bibliographie. Il est vrai que nous ne sommes qu'à l'aube de tels contentieux – auxquels des questionnaires malaisément interprétables, comme on vient de l'argumenter, prêtent dangereusement le flanc. Il est d'ailleurs à craindre que des actions de groupe ne s'y engouffrent. Quoi qu'il en soit, cette hétérogénéité ne peut que fragiliser l'application de la réglementation et renforcer nos conclusions.

La notion d'adéquation-client développée dans l'article 25 de MIFID-II n'a donc pas été, en raison de la façon dont elle a été mise en œuvre dans la plupart des cas jusqu'ici, une base méthodologique, ni même une inspiration pour gérer le risque-client. Mais comment procéder, alors, pour gérer ce risque ?

Vers une mise en œuvre nouvelle et profitable

de la gestion du risque-client

Toutes les études disponibles du secteur concluent à la nécessité de réorganiser stratégiquement la profession de wealth manager et en particulier de banquier privé autour des besoins et des caractéristiques spécifiques de chaque client. C'est aussi la posture qu'affirment avoir adoptée beaucoup de banques, au moins à travers leurs expressions publicitaires ou leurs sites web respectifs. Cependant, acquérir un client indéterminé de plus n'est pas forcément un plus pour la banque : certains clients coûtent plus cher que d'autres, certains coûtent si cher qu'ils peuvent dans des cas jadis extrêmes, mais de moins en moins rares, ne pas être rentables. Il arrive parfois même que pour des clients privés ayant plusieurs centaines de millions d'euros dans une banque, cette dernière perde effectivement de l'argent avec ce type de clients (seuls les revenus par client sont mesurés, mais pas la ventilation des coûts), mais ne se résigne jamais à s'en séparer en raison de la perte d'encours que cela engendrerait : dans les résultats publiés, les baisses de collecte d'encours peuvent diminuer l'attirance de clients pour la banque.

Suffit-il alors de pouvoir disposer d'un cadre permettant d'individualiser les coûts (et pas seulement les bénéfices) attendus du client ? Oui, mais à condition de pouvoir disposer de ces informations sous forme de distributions de probabilité : idéalement, il faut pouvoir évaluer la distribution de probabilité des divers avantages apportés par un client et mettre dans l'autre plateau de la balance la distribution des coûts qu'il est susceptible d'entraîner pour la banque. La seconde distribution doit en particulier inclure le risque de retrait de fonds sous gestion et doit se comprendre comme une mesure proactive et pas seulement appuyée sur les observations passées. C'est en effet dans ce rapprochement entre tolérance au risque attendue d'un investisseur et volatilité prévue du marché que réside le fondement d'une gestion proactive du risque-client. Cela implique de savoir mesurer la première et prévoir la seconde. Cet article se focalise sur la mesure de la tolérance/aversion au risque, laissant pour d'autres développements les techniques de prévision de volatilité les plus performantes.

Arbitrage risque-rendement ou fonction d'utilité :

quelques rappels historiques utiles.

Arbitrer entre risque et rendement est devenu, depuis les travaux de Markowitz des années 1950, le terme de référence de l'aversion ou de la tolérance au risque d'un investisseur. Ce n'est pourtant qu'un aboutissement de trois étapes successives de la pensée financière, qu'il est bon de retracer rapidement pour pouvoir saisir l'élargissement introduit depuis une vingtaine d'années par une quatrième étape proposant de nouvelles mesures de tolérance au risque, dont l'importance pour la profession pourra alors être évaluée.

Pour rendre aussi concis que possible ces rappels, nous convenons d'écrire :

(x1, p1 ; x2, p2 ; ..., xn, pn)

L'actif financier (ou le « prospect », de façon générique) qui procure un rendement x1 avec une probabilité p1, supposée ici connue ; x2 avec une probabilité p2 ; …, xn avec une probabilité pn17. Les x1 peuvent être des gains, des rendements positifs, ou des pertes (notées négativement).

La question de l'arbitrage risque-rendement d'un investisseur revient à se demander comment ce dernier va classer, selon les rendements et les risques qu'ils représentent respectivement à ses yeux, divers actifs, ou, de façon équivalente, quelle évaluation personnelle cet investisseur donnera de chacun des actifs, ce qui permettra de les classer et de déduire de ce classement les arbitrages personnels de cet investisseur. Nous examinons dans le reste de ce paragraphe les trois réponses successives de la pensée scientifique à cette question. Nous pourrons ainsi examiner et apprécier la réponse actuelle au paragraphe suivant.

Première réponse

C'est celle de Pascal, Fermat et Huyghens, au cours du xviie siècle, arrivés chacun indépendamment à la conclusion que l'évaluation U de cet actif doit (notez le caractère normatif de la proposition) être fixée par l'espérance mathématique de la distribution des rendements, soit :

U (x1, p1 ; x2, p2 ; ..., xn, pn) = x1.p1 + x2.p2 + ... + xn.pn

Cette règle d'évaluation, dite de l'espérance de gain, figure dans le Traité d'arithmétique de Pascal dès 1624, sera réaffirmée en 1654 à propos de jeux d'argent et sera généralisée à des domaines très larges – jusqu'au domaine métaphysique ! – par son auteur dans le Manuscrit de Port-Royal (1670) devenant alors le fameux « Pari de Pascal ».

Pourtant, un siècle plus tard, Nicolas Bernoulli signalera qu'à la cour de Saint-Pétersbourg, le comportement des courtisans ne se conforme apparemment pas à cette règle d'évaluation, si convaincante en apparence. La lettre qu'il envoie en 1709 à travers toute l'Europe formule ce qui deviendra le célèbre « Paradoxe de Saint-Pétersbourg », que l'on peut présenter sous forme d'une expérimentation in vivo. Nicolas Bernoulli a en effet proposé à divers courtisans du tsar d'évaluer un jeu de hasard dont les règles impliquent une espérance mathématique de gain infinie18. Or aucun des participants à l'expérimentation ne proposera d'investir ni sa fortune entière, ni même des sommes très élevées, pour participer au jeu. Certes il ne s'agit que d'une description des comportements face au risque, alors que la règle de Pascal était normative. Mais 100 % d'observations contraires à la règle obligent à remettre cette dernière en question.

Les courtisans ont-ils tous tort ? Sont-ils tous irrationnels ? Ou la règle du gain espéré est-elle trop restrictive du point de vue de la description des comportements d'investissement face au risque, et, dans ce cas, comment justifier les évaluations des courtisans ? Une série de réponses seront apportées tout au long du xviiie siècle (jusqu'à 1777), sans qu'aucune ne s'impose alors. Ce sont les travaux de John Von Neumann et d'Oskar Morgenstern, publiés en 1947, qui imposeront la solution publiée en 1738 dans les comptes rendus de l'Académie des sciences de Saint-Pétersbourg par Daniel Bernoulli, professeur à Bâle et cousin de Nicolas, comme la plus significative. Ce sera la deuxième réponse à la question posée.

Deuxième réponse

Daniel Bernoulli avait en effet eu l'intuition remarquable que la notion de gain ne pouvait s'apprécier que de façon contingente, en confrontant la situation personnelle de chaque individu aux risques auxquels un investissement le conduit à faire face, lorsque des montants importants sont en jeu. Il suggéra donc de substituer à la notion de gain monétaire – identique pour tous – une notion d'emolumentum (les scientifiques de l'Europe écrivaient alors en latin) permettant de déterminer l'évaluation personnelle d'un actif résultant de cette confrontation. La notion a été traduite chez les économistes par « utilité ».

Une justification minimale de cette notion est à la base du raisonnement de Daniel Bernoulli : l'utilité d'un gain dx « négligeable » par rapport à une fortune personnelle F doit être elle-même « petite » (on l'écrira donc : du), mais proportionnelle à ce petit gain (du = a.dx). Cependant, elle doit en même temps être inversement proportionnelle à la fortune F, conformément à l'observation constante qu'un gain de 1 dollar représente pour un individu pauvre une grande importance (de nos jours encore, cela peut équivaloir à une demi-journée de survie d'une personne pour 10 % de l'humanité), alors qu'il est à peine perceptible pour un individu très riche (Warren Buffet ressent-il les variations de sa fortune au dollar près ?). Dès lors, Daniel Bernoulli peut démontrer que pour avoir l'utilité u d'un gain quelconque x, il faudra substituer à la valeur x de chacun des gains possibles x l'utilité de ce gain :

u(x) = a.ln(F + x/F)

Et ainsi, l'évaluation d'ensemble de l'actif U peut s'écrire comme une somme pondérée de l'évaluation de chaque actif :

pnU(x1, p1 ; x2, p2 ; ..., xn) = a.ln(F + x1/F)p1 +... + a.ln(F + xn/F)pn

où a est un paramètre (toujours positif) correspondant aux préférences personnelles de l'investisseur, ln le symbole habituel de la fonction logarithme naturel et F la fortune de cet individu (supposée toujours positive aussi). Cette modification de la règle de Pascal rend alors l'espérance du jeu de Saint-Pétersbourg finie. Nicolas Bernoulli avait-il, à sa grande surprise, enregistré un prix maximal accepté pour participer au jeu de 20 ducats ? Daniel montrera en s'appuyant sur ses deux arguments que c'est à peu près ce qu'un individu doté d'une immense fortune F accepterait de payer pour ce jeu.

Cette deuxième réponse à la question du choix en situation risquée offre une description possible – il y en a eu d'autres, comme on l'a évoqué – des observations de Nicolas Bernoulli, mais elle conduit à une forme logarithmique de l'utilité peut-être trop restrictive, car fondée sur les deux arguments – discutables et surtout incomplets, insuffisants – évoqués supra. La finance comportementale d'aujourd'hui nous fournit des arguments à foison qui permettent de cerner cette incomplétude. L'analyse Bernoullienne ne fournit pas d'outil général permettant de déterminer de façon scientifique la fonction d'utilité d'un investisseur donné face à un investissement risqué donné. Elle ne permet donc pas davantage d'affirmer quels critères de choix rationnel un investisseur confronté à un tel choix risqué devrait en général respecter. Une nouvelle réponse était donc indispensable.

Troisième réponse

Il appartiendra à John Von Neumann et Oskar Morgenstern de franchir, en 1947, ce pas décisif. Leur analyse consiste à définir les préférences élémentaires (à travers une fonction d'utilité) d'un individu, non à partir des rendements ou des pertes identifiés isolément, qu'il faut ensuite ajouter ou retrancher de la fortune initiale F, mais sur une distribution de probabilité de rendements venant ajouter à la fortune initiale de l'investisseur un gain possible ou en retrancher une perte éventuelle. Les préférences de l'investisseur ainsi définies essaient donc de tenir compte d'un ensemble de gains ou de pertes auxquels l'individu fait face, ce qui n'était pas le cas chez Daniel Bernoulli. Von Neumann et Morgenstern s'efforcent ainsi de mieux rendre compte de la confrontation évoquée plus haut. Il leur est alors possible, en acceptant quelques axiomes plausibles, de formuler une théorie normative du choix rationnel. Le classement des investissements risqués du point de vue d'un investisseur i donné parmi une série d'investissements possibles – c'est la contingence déjà évoquée – doit alors s'appuyer sur l'espérance mathématique de la fonction d'utilité ainsi définie de cet investisseur ui dite « fonction d'utilité Von Neumann-Morgenstern » (VNM). L'investissement qui doit alors être choisi est celui qui correspond au maximum de l'espérance de cette d'utilité ui. On revient donc à une théorie normative : une fois la fonction d'utilité ui de l'investisseur i connue, la rationalité implique de choisir l'investissement conduisant à maximiser l'espérance mathématique de cette fonction19 :

u(x1, p1 ; x2, p2 ; ..., xn, pn) = u(x1)p1 + u(x2)p2 + ... + u(xn)pn

Même si l'explication par Daniel Bernoulli des comportements observés a incontestablement fourni à Von Neumann et Morgenstern l'inspiration de départ, la théorie VNM n'est pas une généralisation descriptive de l'analyse Bernoullienne, mais bel et bien une généralisation normative de la règle de Pascal. Il est d'ailleurs intuitif que si tous les montants en jeux dans la distribution de probabilité sont faibles eu égard à la fortune de l'individu, l'espérance d'utilité VNM ne sera guère différente de l'espérance mathématique des valeurs « finales » Fi + xi possibles de la fortune de l'investisseur i et que la nouvelle règle VNM de rationalité se confondra alors avec celle de Pascal, qui n'en est qu'un cas particulier. Comme l'enseignait à Harvard dans les années 1950 Robert Schlaifer, recourir à la règle d'utilité espérée à la place de celle du gain espéré se justifie lorsque les montants en jeu sont importants.

C'est cette règle VNM qui a engendré l'arbitrage risque-rendement couramment utilisé aujourd'hui. Cet arbitrage correspond au cas particulier où toutes les distributions d'investissements possibles sur le marché sont des lois normales. Dans ce cas en effet, choisir entre elles ne dépend que de l'espérance et de la variance de chaque actif financier, ce que peut exprimer l'espérance d'une fonction d'utilité particulière (de forme quadratique) :

p1.ui(Fi + x1) + p2.ui(Fi + x2) + ... + pn.ui(Fi + xn) = Ui[Fi + E(x),o2(x), bi]

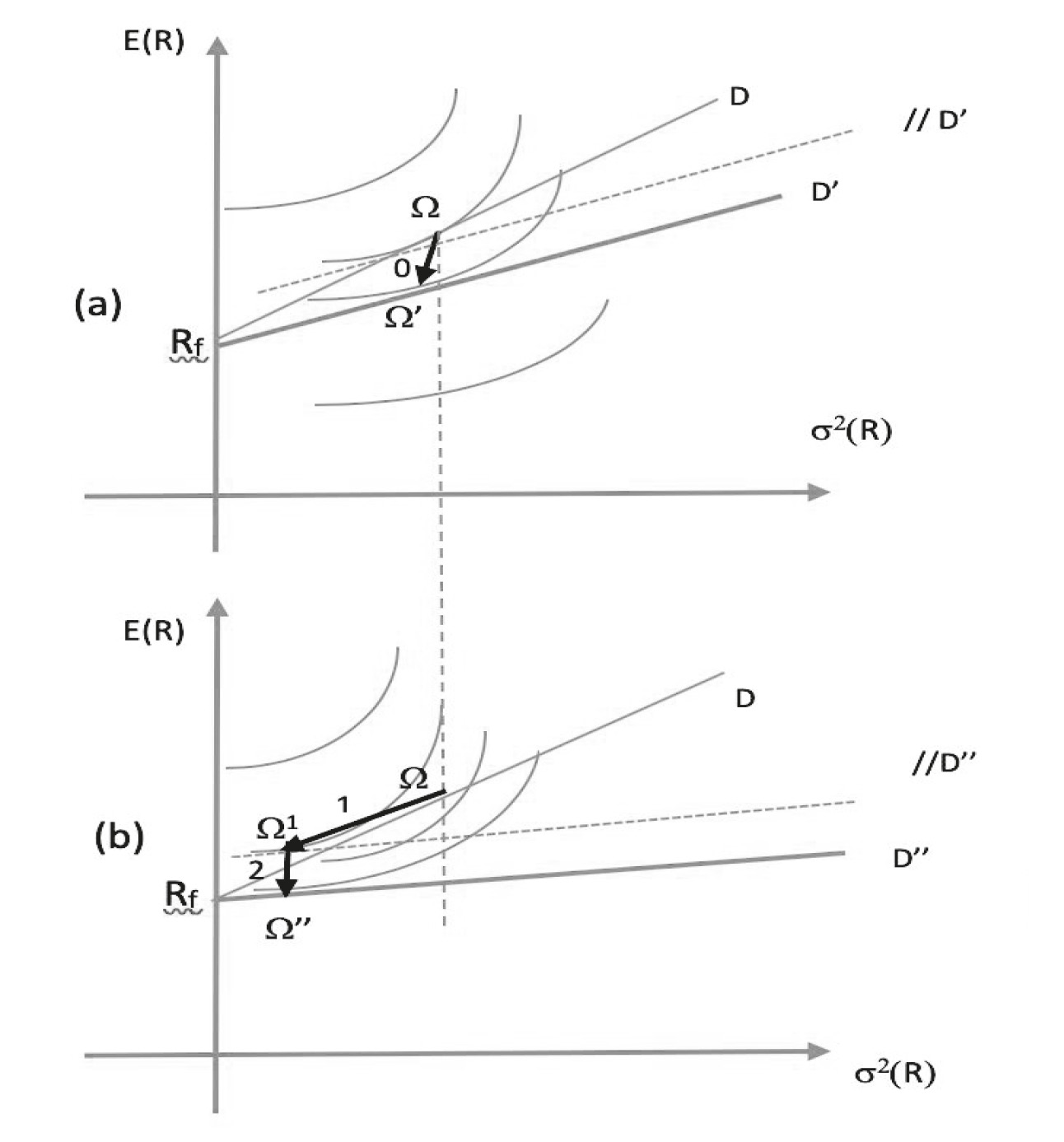

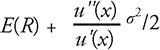

où Fi est la fortune de départ donnée de l'investisseur i et bi est un paramètre fixe caractérisant la psychologie du risque de cet investisseur i. L'espérance d'utilité permet pour tous les types de distributions20 la détermination précise d'un arbitrage (variant d'un contexte à un autre) entre l'espérance des rendements E(x) et leur écart type s(x), ce dernier étant considéré comme une bonne appréhension du risque. Elle seule permet de quantifier l'arbitrage risque-rendement spécifique que l'investisseur effectue entre les actifs qui lui sont proposés. Cette remarque est d'autant plus importante que l'investisseur lui-même peine la plupart du temps à déterminer directement cet arbitrage et qu'il est toujours plus facile et surtout plus précis de lui faire révéler sa fonction d'utilité – c'est tout l'art de l'élicitation, mise au point par vingt-cinq ans de finance expérimen tale – pour découvrir quels sont précisément les arbitrages risque-rendement qui guident les choix de l'investisseur. Pour ce faire, on détermine un score personnel de l'investisseur pour chaque actif financier en fonction de l'espérance des gains nets, de la variance de ces gains et de la forme de la fonction d'utilité : l'arbitrage de l'investisseur entre deux actifs consiste tout simplement à choisir l'actif dont le score est le plus élevé. Le score – dit « équivalent-certain » – se calcule comme :

où u''(x) désigne la dérivée seconde de u(x), u'(x) la dérivée première, et 2 la variance de x. Le rapport u''(x)/u'(x) est l'aversion au risque de l'investisseur. Comme u'(x) est nécessairement positif, le signe de l'aversion au risque dépend uniquement de u''(x). Si u''(x) < 0 (fonction d'utilité concave), la correction à apporter à E(R) est positive et on parle alors d'aversion au risque VNM. C'est son inverse que l'on appelle la tolérance au risque VNM. La recherche a peu à peu conduit à mettre au point des techniques d'élicitation précises de la fonction d'utilité et donc de la tolérance au risque VNM. Les résultats obtenus sont devenus très largement reproductibles, comme déjà évoqué plus haut, et ont pu acquérir ainsi un véritable statut scientifique, moins éloigné que l'on ne croit souvent du statut que l'on confère sans barguigner aux résultats obtenus en sciences « dures ». La fonction d'utilité d'un individu donné, face à un ensemble d'investissements donnés sur lesquels il dispose d'informations données, est recueillie de façon stable d'une expérimentation à l'autre. II en va donc de même de la tolérance au risque VNM.

L'analyse du risque VNM a remarquablement réussi à établir une théorie normative du choix d'investissement qui généralise la règle de Pascal tout en spécifiant la solution adaptée à chaque individu. Pour autant, une série d'expérimentations conduites dans les années 1950, puis 1970 ont permis de comprendre, à la suite du Paradoxe d'Allais21, que la règle d'utilité espérée ne fournissait pas de représentation suffisamment générale des comportements face au risque. Du même coup, comme les résultats expérimentaux obtenus laissaient apparaître des régularités frappantes, il n'était plus possible de se contenter d'enregistrer les observations expérimentales comme autant de contre- exemples à la règle VNM. L'élaboration de modèles se conformant aux principaux résultats observés est devenue le but premier de beaucoup de chercheurs dès le début les années 1980 (Machina, 1982). Et c'est ainsi que la quatrième réponse à la question posée a peu à peu émergé. Elle constitue aujourd'hui un état de l'art éprouvé et soutenu par de très nombreux tests statistiques, que ce soit au niveau individuel ou au niveau du marché. On ne peut, dans le cadre du présent article, que renvoyer à Chiappori et al. (2019), qui complètent et renouvellent à la fois les analyses statistiques des années 1990 et concluent à la nécessité de transformations non linéaires des probabilités pour représenter les comportements risqués. Ils soulignent en particulier que le modèle à dépendance de rangs que nous allons évoquer maintenant est le seul véritablement significatif.

Quatrième réponse : mesure contemporaine de la tolérance au risque

En négligeant dans le cadre de cet exposé les détails techniques, remarquons que l'essence de la règle de Von Neumann et Morgenstern du maximum d'utilité espérée a consisté à tenir compte de l'attitude par rapport au risque d'un investisseur en corrigeant, dans la règle de Pascal, de façon propre à chaque individu, gains et pertes à envisager, de façon subtile et adaptée à chaque individu. Malgré ces progrès, force a été de constater qu'une théorie rendant fidèlement compte de la tolérance au risque d'un individu avait besoin d'une analyse plus générale. Des observations pratiques permettent de faire ici l'économie d'un exposé technique des résultats de la recherche, validés par ailleurs comme on vient de l'évoquer.

C'est en effet une constatation largement partagée que la présentation d'un fonds doté de performances passées bien identifiées ne recueille pas le même succès auprès d'investisseurs donnés, fût-ce à une ou deux semaines d'intervalle, selon que les informations générales dont ces investisseurs disposent22 – ou les opinions recueillies dans leur entourage – rendent leur perception du monde riante ou sombre, par exemple pointent vers une embellie économique ou au contraire vers une récession. Pourtant les probabilités « historiques » qui caractérisent les performances du fonds restent les mêmes dans un tel intervalle de temps, tout comme la fonction d'utilité – et donc la tolérance au risque VNM – de chaque investisseur. On est donc conduit à en déduire que les investisseurs modifient les probabilités historiques ou les fréquences, même correctement établies, même recueillies sur des périodes suffisamment longues, en fonction de variables qu'énumère la finance comportementale et que la pratique professionnelle constate régulièrement.

Les psychologues avaient formulé des intuitions voisines depuis les années 1930. Mais les modifications trop simples de la règle VNM qu'ils proposaient depuis les années 1950 n'étaient pas dénuées de graves problèmes : elles conduisaient trop souvent à conseiller de choisir un investissement proposant des rendements moins favorables dans certains scénarios possibles sans proposer de meilleurs résultats dans aucun des autres scénarios ! La « Prospect Theory » (PT) de Kahneman et Tversky (1979) en est l'exemple le plus connu23, bien qu'elle ait été précédée de nombreux modèles du même type24. Le modèle qui a permis de surmonter cette difficulté, en proposant une autre façon, plus subtile, de transformer les probabilités, est dû à un économiste australien, Quiggin (1982, 1993), s'appuyant sur une idée due à Allais (1953)25. Sans connaître les écrits de Quiggin, Allais a finalement développé en 198826 sa propre intuition des années 1950, parvenant à des résultats évidemment très voisins de ceux de Quiggin. Un superbe cas de découverte mertonnienne.

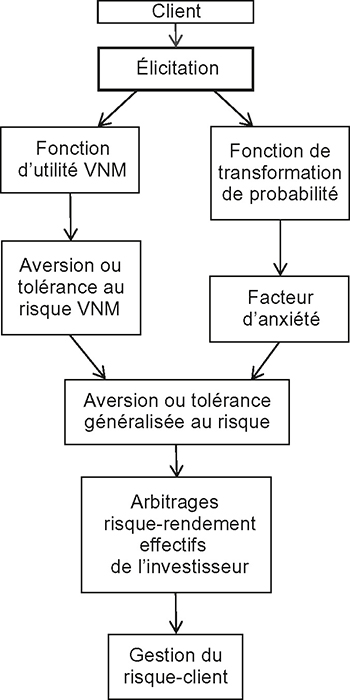

L'importance pour la gestion du risque-client

de ces mesures nouvelles

Sans entrer dans le détail, on peut dire que le très grand intérêt de ce « modèle à dépendance de rangs » de Quiggin-Allais tient au fait qu'il est possible de distinguer, dans la tolérance au risque, ce qui tient aux caractéristiques intrinsèques de l'individu – la fonction d'utilité u – de ce qui tient à la part d'anxiété de cet individu quant à son environnement. Il faut pour cela s'appuyer sur une fonction j, dite de « transformation de probabilité ».

En convenant d'ordonner de façon croissante (en allant donc des plus fortes pertes possibles jusqu'au rendement potentiel le plus élevé) les résultats possibles d'un actif (x1 < x2 < x3 < … < xn), on peut représenter le raisonnement de l'investisseur de la façon suivante : le rendement x1 étant le minimum, il est certain de ce rendement et pondère ainsi l'utilité de x1 par la probabilité 1, puis il considère la possibilité d'un incrément [u(x2) – u(x1)] qu'il pondère par la probabilité d'obtenir cet incrément soit (1 – p1 = p2 +…+ pn), transformée par la fonction j, etc. jusqu'à la possibilité d'obtenir un ultime incrément de rendement [u(xn) – u(xn – 1)], qu'il pondère par la probabilité de l'obtenir, soit pn, transformée à son tour par la fonction θ27. Dans le cas particulier où la fonction j n'est pas une transformation et où θ(p) = p, le calcul permet immédiatement de retrouver la règle VNM. Il s'agit donc d'une généralisation directe de cette dernière.

Pour autant, la généralisation est de grande importance. En effet, la tolérance au risque est désormais appuyée sur deux fonctions, l'une – l'utilité VNM – caractéristique intrinsèque de l'individu, caractéristique de la troisième réponse et base des pratiques actuelles, l'autre – la fonction j – caractéristique des divers facteurs que la finance comportementale suggère et que l'on pourrait décrire comme la « résultante » des rapports entre l'individu et le monde qui l'entoure au sens le plus général de l'expression. Cette fonction traduit un comportement « globalement optimiste » lorsqu'elle est concave ou « globalement pessimiste » lorsqu'elle est convexe, cette propriété pouvant être locale (in the small) ou d'ensemble (in the large).

À partir de cette fonction, il est possible de dériver un facteur d'anxiété qui impacte de façon spécifique la tolérance au risque. C'est ce facteur, allant d'une confiance totale dans les mouvements de marché à la panique face à de tels mouvements, qui permet de fonder une gestion véritablement proactive du risque-client. En effet, face à un changement d'orientation du marché, le facteur d'anxiété aura un impact plus important sur la volonté de retirer les fonds sous gestion que la tolérance au risque VNM. On peut le voir à partir d'un exemple stylisé très simple, consigné en annexe et illustré par deux graphiques suggestifs.

Le schéma infra résume la démarche d'ensemble proposée dans cet article.

Profilage de risque nouvelle génération

et gestion du risque-client

Source : schéma original des auteurs.

Seul ce nouveau type d'analyse permet de comprendre nombre de constatations en finance et notamment les retraits importants d'actifs constatés au dernier trimestre 2018 dans diverses banques privées d'importance reconnue, déjà signalés en introduction à cet article. Ce sont les situations de ce type qu'un profilage de risque significatif dès le départ – et périodiquement ajusté ensuite – permet de gérer de façon la plus efficace possible en pratique. Au niveau collectif, la désaffection pour les actions depuis une quinzaine d'années peut s'expliquer en partie par ce facteur d'anxiété. La fonction θ conserve en effet un impact au niveau du marché.

L'avenir du profilage de risque digital mixte.

Pour la profession, mesurer ainsi la tolérance au risque de façon générale et le facteur d'anxiété plus particulièrement permet en effet une appréhension effective du risque de voir le client soit se plaindre de l'exposition du portefeuille (tolérance au risque proche des comportements effectifs) en exigeant de le recomposer, soit retirer ses fonds, soit se plaindre en justice des résultats en les reliant à l'exposition erronée de son portefeuille en exigeant une compensation, négociée ou judiciaire (action individuelle ou de groupe).

Dans les trois cas, dont les exemples abondent, un coût est généré pour l'institution gestionnaire, qui affecte de façon inopinée les résultats de l'institution. C'est ce risque qu'il faut gérer de façon proactive, c'est-à-dire en évaluant le facteur d'anxiété et la vraisemblance de l'un des trois événements que l'on vient d'évoquer pour les clients et en affectant en conséquence les ressources disponibles pour « mitiger » ce risque spécifique (c'est-à-dire modifier les conséquences ressenties pour certains des scénarios afférents à ce risque). Ces ressources peuvent se décliner soit en termes financiers purs, soit en termes d'actions de marketing direct personnalisé, soit en termes de ressources humaines, etc.

On peut certes avoir une idée, ex post, du « risque-client » en repérant dans le passé les événements correspondants aux divers cas évoqués ci-dessus. Mais le risk management en matière de gestion de fortune consiste à optimiser la prise de risque de l'institution gestionnaire vis-à-vis du client ex ante. Et il faut pour cela avoir l'explication des comportements pour pouvoir les anticiper correctement. Il est alors possible de savoir par avance combien de ressources allouer à la gestion de chaque client, que ces ressources se traduisent par des actions préventives de fidélisation du client comme on l'a esquissé supra ou qu'elles se traduisent par une recherche plus poussée d'adéquation du portefeuille constitué pour le client. Par exemple, à ce dernier égard, au lieu de « faire entrer » le client dans un fonds appartenant à l'institution gestionnaire (profitabilité à court terme), on recherchera dès le départ une composition plus finement adaptée de son portefeuille. On peut également faire procéder (sans coût supplémentaire) à des élicitations de profil plus fréquentes28 permettant des ajustements de portefeuille dynamiques mieux personnalisés – sans pour autant avoir besoin de modèles compliqués à la portée pratique discutable.

Dans chaque cas, la profitabilité immédiate peut être affectée, mais la profitabilité à long terme sera mieux assurée. Le management des risques consiste ici à déterminer dès le départ quel montant de ressources de fidélisation allouer à chaque client, quitte à réviser ce montant au fur et à mesure par les observations de l'expérience et les élicitations périodiques du profil de risque. Ce dernier résulte donc maintenant de trois éléments : tolérance au risque, facteur d'anxiété, capacité à porter le risque. Mais sur quel outil s'appuyer pour atteindre à cette connaissance suffisante du client ?

Les questionnaires comportant des questions fixes présentent des faiblesses et conduisent à des erreurs de diagnostic signalées en première partie. Ils ne sont en aucune façon susceptibles de mesurer une tolérance au risque, ni VNM, ni généralisée, encore moins de fournir un support à la gestion du risque-client. Un logiciel interactif peut seul conduire à cerner l'attitude (subjective) face au risque et le facteur d'anxiété dans un intervalle de temps raisonnable. Seul un outil informatique est susceptible de reproduire avec un minimum de biais les protocoles mis au point par la recherche expérimentale.

On ne peut donc songer qu'à un outil digital. Dans le domaine précis visé par cet article, la profession appelle ces outils – de façon discutable – des « robots de conseil » (robot-advisors). Il en existe de plusieurs types et un choix s'avère donc inéluctable. Jusqu'à présent, le choix ne pouvait être guidé par les premiers retours d'expériences enregistrés. Mais on dispose maintenant des jugements et de l'expérience de certaines firmes FinTech qui ont été primo-utilisatrices (Nutmeg, par exemple) et ont peut-être lancé leur équipement trop tôt. Dans un premier temps, les professionnels du conseil financier ont pu craindre pour la survie de leurs activités, mais ont été (trop) vite rassurés, l'impact ayant été minime à ce moment-là. Il y a d'ailleurs à cela une explication subtile : les robots de conseil digital complètement automatisés ne se sont pas avérés rentables pour les « primo-utilisatrices » – FinTech, dont la clientèle était encore trop restreinte : leur coût aurait nécessité que les clients maintiennent dix ans de suite le même montant de fonds dans ces firmes de taille restreinte, alors qu'il s'est surtout agi de clients majoritairement désireux de sortir en quelques années au plus (exemple de Nutmeg). Aussi ces firmes-là cherchent-elles désormais à s'équiper en robots « mixtes », c'est-à-dire de machines produisant de l'information pour aider le conseiller à formuler sa recommandation, le gestionnaire de compte pouvant aussi se servir de cette information pour composer un portefeuille adéquat (suitable). Il n'est donc pas question de chercher à supplanter le conseiller, mais de rendre son diagnostic plus sûr et plus facile à la fois. Et il s'agit aussi de faciliter la coordination entre chargé de clientèle et gestionnaire de compte – ce qui n'est pas un mince problème dans nombre d'établissements au-delà d'une taille vite atteinte. Le tout est aujourd'hui possible à un coût très inférieur à ceux des « robots » entièrement automatisés (produisant directement un portefeuille « optimal » pour le client) de la période précédente.

Ces robots « mixtes » sont ceux que les toutes prochaines années (Stanfield, 2019) vont voir fleurir, non plus seulement dans des FinTech de gestion de fortune, mais dans les banques privées, les compagnies d'assurance, les départements de gestion de fortune de banques commerciales, etc., qui s'avèrent déjà les plus profitables. Ils permettent en effet de véritablement gérer le risque-client dans son ampleur nouvelle – et, par la même occasion, de marquer le début d'une application sincère (et rentable) de MIFID-II ou/et des réglementations du même type.

Il ne faut pas confondre ces logiciels avec ceux – déjà évoqués plus haut – qui ont déjà plus ou moins envahi les marchés financiers et qui ont été destinés avant tout à permettre une communication facile et quasi instantanée entre la banque et ses clients. Ceux qui sont en passe de prendre pied dans les banques privées ou chez les autres gestionnaires de fortune évoqués sont destinés à produire de l'information supplémentaire pour aider les conseillers à élaborer des propositions commerciales adaptées aux préférences personnelles « fines » de leur clientèle, permettant aussi bien de gérer de façon proactive le risque-client que de remplir, enfin, le cahier des charges défini par MIFID-II dans son article 25. À cet égard, il est crucial que le robot choisi puisse adapter ses paramètres de fonctionnement au contexte spécifique à chaque investisseur avant de fournir, en sortie, les trois éléments du profil de risque ainsi que diverses caractéristiques d'une distribution de rendements adaptée à fidéliser le client29. Ce n'est que par cet intermédiaire que l'on pourra à la fois allouer les budgets de façon efficiente pour gérer le risque-client et en même temps se délivrer de recommandations quasi standardisées déjà dénoncées en première partie de cet article.

Conclusion : profitabilité et conformité

réconciliées par la gestion du risque-client

Les banques privées sont au tournant d'un aggiornamento de leur métier, que certaines parmi les plus profitables ont déjà commencé d'entreprendre. À l'encontre des objectifs qui lui ont donné naissance, la réglementation MIFID-II, en particulier la mise en œuvre de son article 25 visant à une plus grande protection des clients utilisant des services financiers, s'est avérée décevante, voire contre-productive : surcroît administratif sans valeur ajoutée bien identifié hormis le fait d'avoir les documents adéquats dans l'éventualité d'un contrôle ou d'un litige entre la banque et le client, augmentation des coûts (mise en place d'outils de surveillance d'adéquation des portefeuilles en fonction des profils de risque des clients, recrutement d'équipes dédiées à la gestion du risque adéquation, arbitrage des portefeuilles gérés en advisory en cas d'identification de non-adéquation, etc.), homogénéisation et standardisation de l'offre et des portefeuilles conduisant le plus souvent à une performance décevante pour les clients et à un sentiment d'offre bancaire formatée sans véritable relation avec leurs besoins exprimés. Cette insatisfaction conduit depuis quelques années ces derniers à se détourner des banques privées traditionnelles (ou départements de banque privée de banques universelles) et à rechercher un service plus personnalisé dans des multi-family offices ou des acteurs du wealth management appréhendés davantage comme des boutiques perçues comme mieux à même de prendre en compte leur appétence ou leur aversion au risque ainsi que leurs besoins spécifiques.

Dans le même temps, la digitalisation est aussi entrée en force dans le secteur de la banque privée. Cette dernière a été perçue dans un premier temps comme une menace disruptive par la profession parce qu'elle a avant tout été utilisée comme un instrument drastique de réduction de coûts (et de suppression de postes) alors qu'elle est, dans sa version « mixte » aujourd'hui mieux identifiée, à même d'améliorer de façon significative le service au client privé et d'être une aide essentielle à la décision d'investissement. De plus en plus de clients s'abonnent d'ailleurs déjà d'eux-mêmes à des FinTechs de prédiction algorithmique des marchés et demandent à leurs banquiers de mettre en place avec eux des stratégies d'investissement s'en inspirant. Se servir de la digitalisation pour mieux cerner le profil du client en élicitant en amont son appétence au risque et son facteur d'anxiété permet à la fois de gérer de manière plus efficace le risque de retrait potentiel de fonds, voire de défection du client, tout en satisfaisant de façon plus judicieuse à la réglementation MIFID-II.

En effet, le coût d'acquisition d'un client n'est pas la seule « variable clé » pour les banques privées ou les gestionnaires de fortune. Acquérir un client indéterminé de plus n'est pas forcément un avantage fixe, ni même toujours un avantage. Certains clients coûtent plus cher que d'autres, certains coûtent si cher qu'ils peuvent – dans des cas jadis extrêmes, mais de moins en moins rares – finir par ne pas être rentables du tout, du fait de leur comportement face au risque de marché. De façon générale, le risque de diverses réactions des clients pèse sur la profitabilité des gestionnaires de fortune, quels qu'ils soient. Gérer ce risque-client est la meilleure façon d'assurer la rentabilité de l'activité de conseil, dont les marges sont les plus prometteuses actuellement, tout en s'en tenant à un respect scrupuleux et intelligent de la réglementation.

Cet ajustement est l'une des facettes de la nécessaire digitalisation de la banque privée. Ainsi l'agilité rendue possible par la digitalisation permet à terme de mieux gérer la profitabilité de chaque client et de mieux assurer sa fidélisation. Un profilage plus nuancé du client aura un impact apprécié sur la performance de son portefeuille et donc in fine sur la satisfaction de chaque client. La digitalisation du profil de risque passe par l'introduction d'un logiciel s'appuyant sur un « robot mixte » combinant intelligence artificielle et finesse du chargé de clientèle, appuyées sur l'analyse du risque contemporaine. Si les algorithmes d'intelligence artificielle des premières générations dans l'industrie bancaire étaient encore relativement grossiers, les derniers ne cessent de s'améliorer pour donner des résultats de plus en plus pertinents pour le profilage du client et les potentielles recommandations de portefeuille en résultant. Les stratégies d'advisory, où le client décide sur la base des conseils dispensés par la banque, en sortiront renforcées.

Cette nouvelle approche aurait également intérêt de s'intégrer dans les modes d'intéraction des « Millenials » appartenant aux nouvelles générations de (U)HNWI. Certes cela peut conduire à réaménager en profondeur la façon de pratiquer le métier de wealth manager, dans les banques privées comme dans les départements de wealth management des banques universelles. Mais c'est précisément ce que recommandent depuis plusieurs années les meilleurs analystes du marché. Comme dans la plupart des industries, la digitalisation pénètre de plus en plus la sphère de la banque privée, y compris dans l'interaction avec les clients et non plus seulement dans la simplification des fonctions de back-office et de trading. Si l'intelligence artificielle permet désormais d'aider les clients en vue de s'habiller en fonction de leur silhouette et de leurs goûts ou de leur proposer des produits cosmétiques, pourquoi n'en irait-il pas de même dans le domaine de la gestion de fortune où la personnalisation du conseil est la clé de la satisfaction du client ? Quelle meilleure opportunité pour cerner les comportements des Millenials fortunés en matière de risque et de comportement bancaire que de mettre en place un profilage de risque digitalisé et de maîtriser par là même le reste des aspects de la gestion de fortune pour cette nouvelle génération de clients si convoités ?